机器学习(四) 机器学习(四) 分类算法--K近邻算法 KNN (下)

2021-07-16 04:06

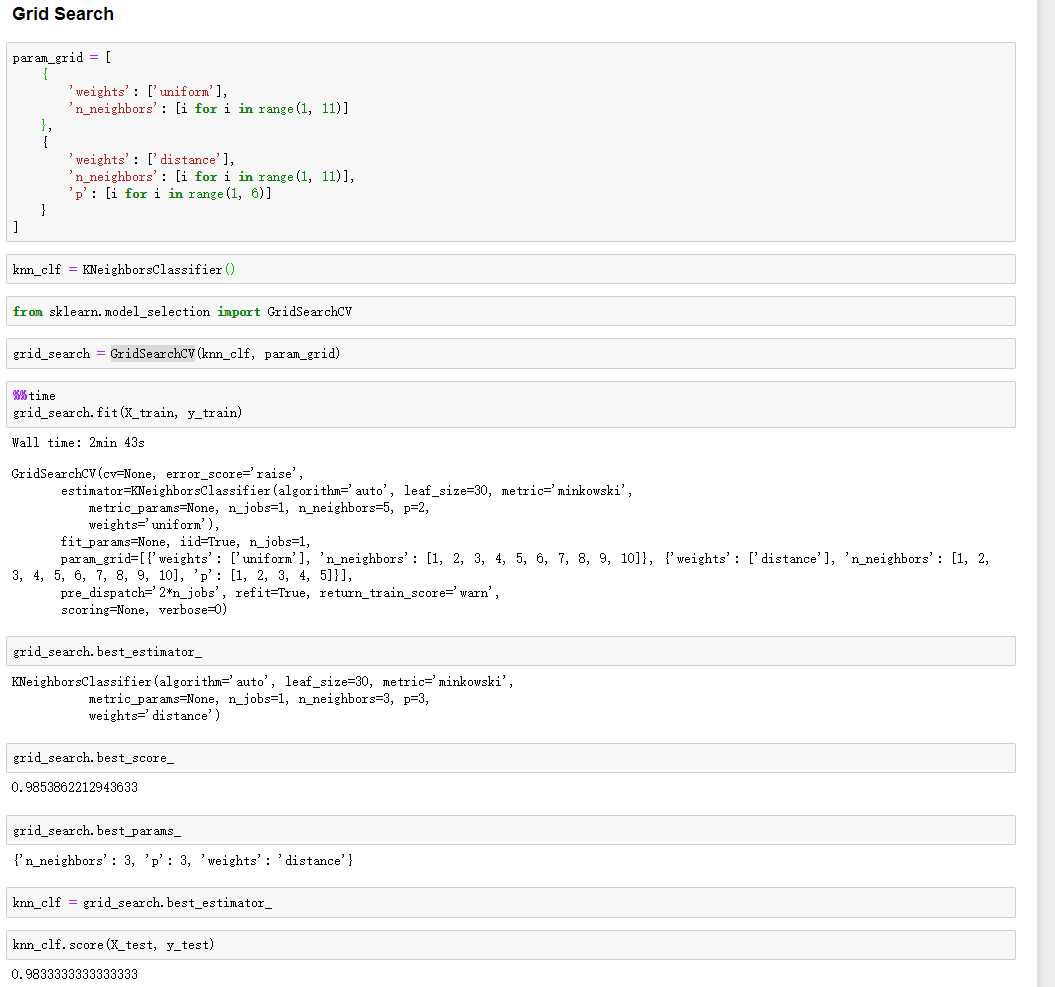

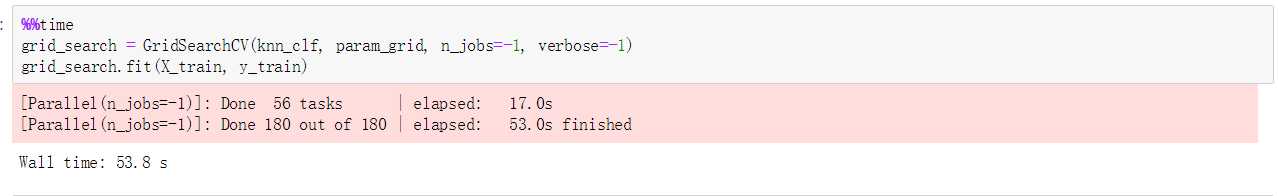

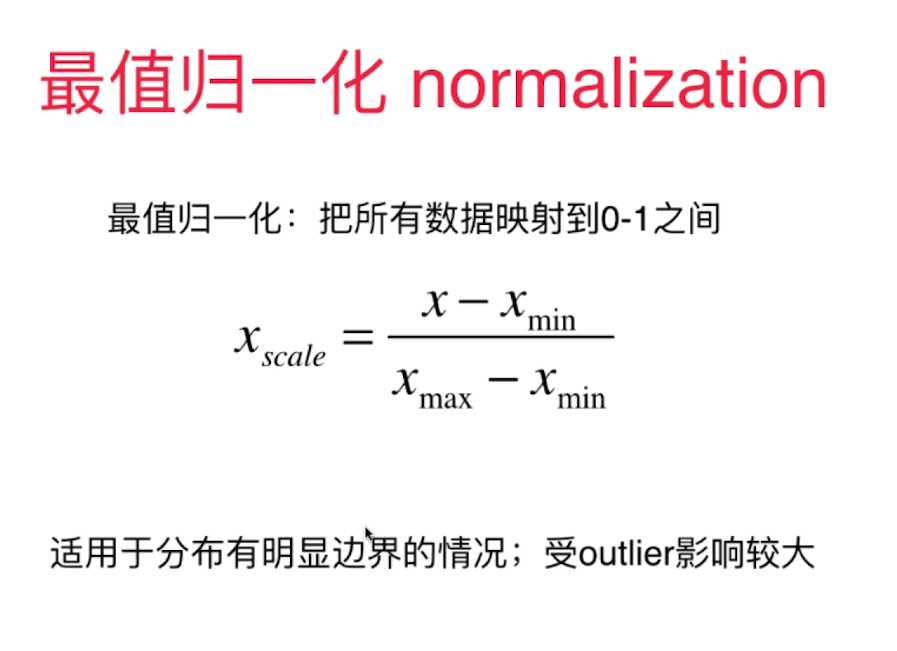

标签:训练 RoCE none 网格 size ext 图片 nta 尺度 解决方案:将所有的数据映射到同一尺度 preprocessing.py 优点: 机器学习(四) 机器学习(四) 分类算法--K近邻算法 KNN (下) 标签:训练 RoCE none 网格 size ext 图片 nta 尺度 原文地址:https://www.cnblogs.com/zhangtaotqy/p/9534929.html六、网格搜索与 K 邻近算法中更多的超参数

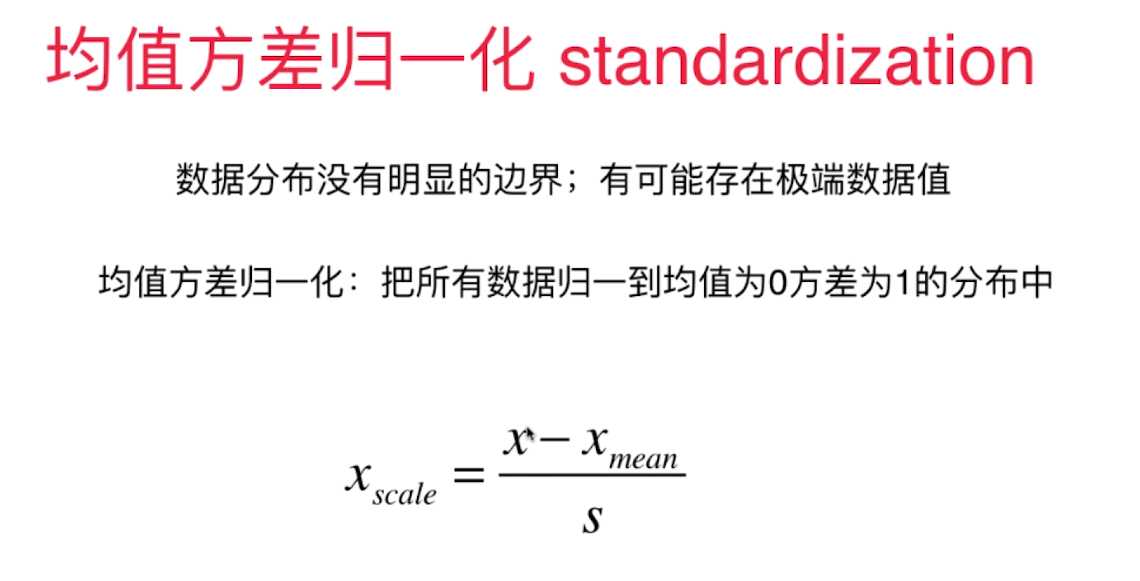

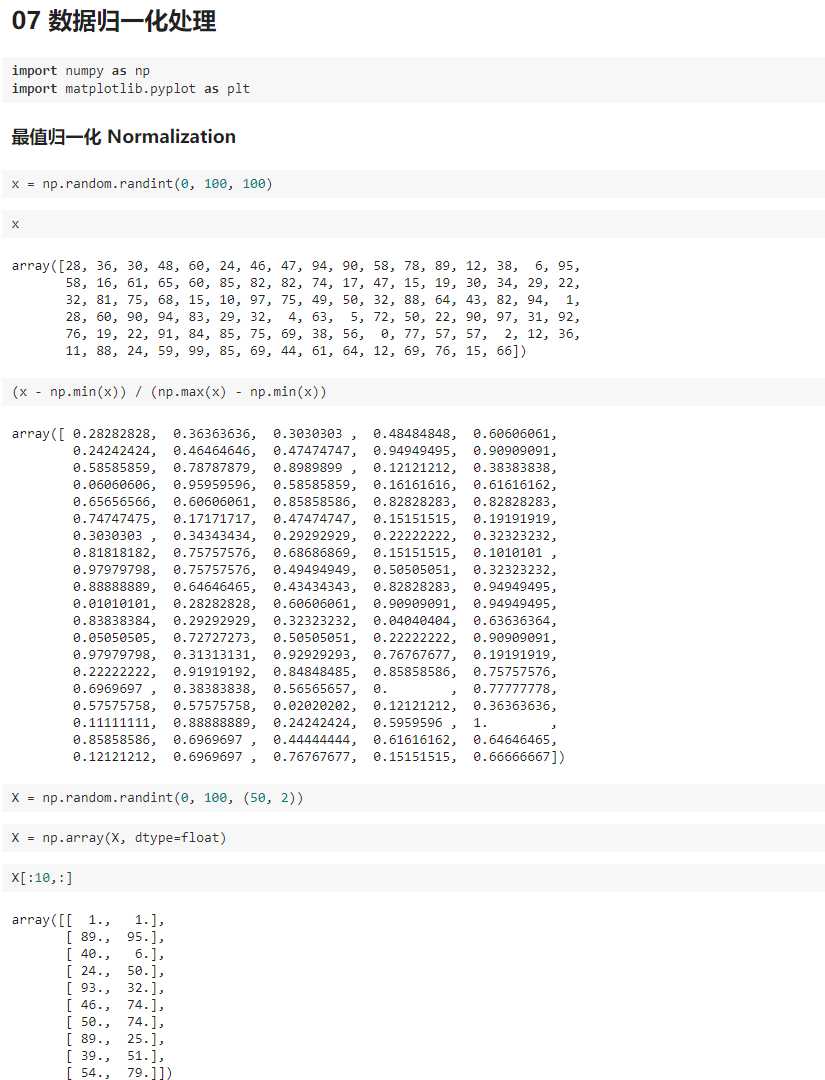

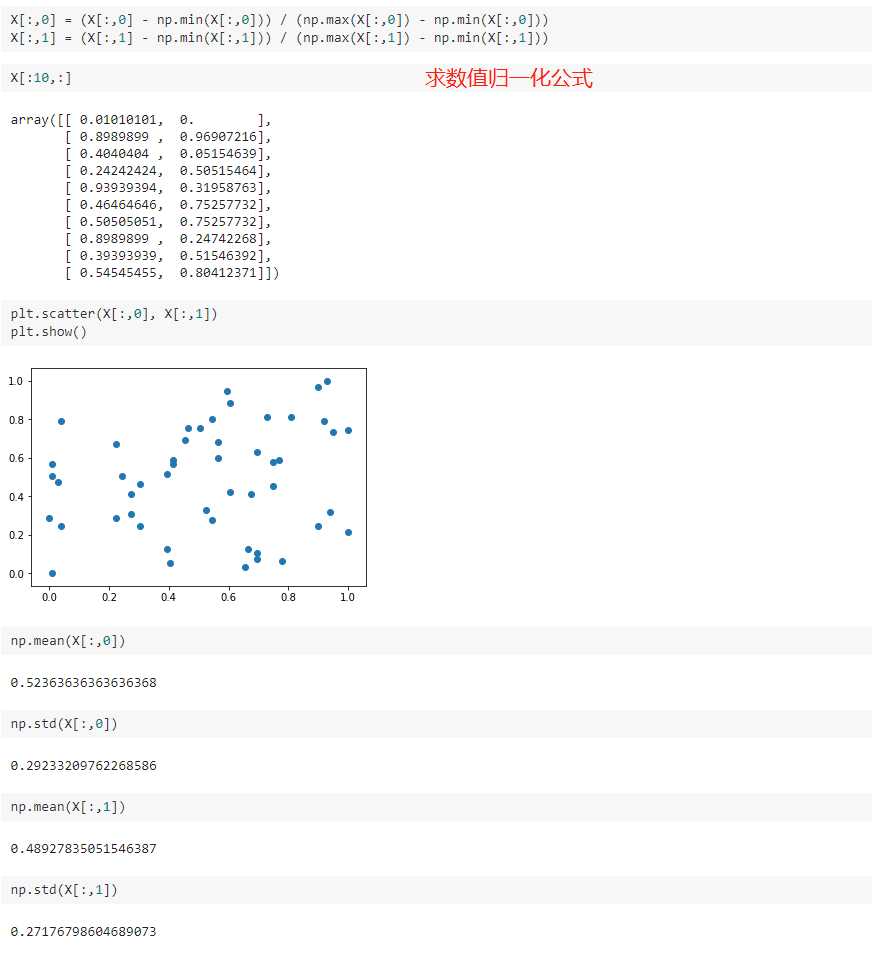

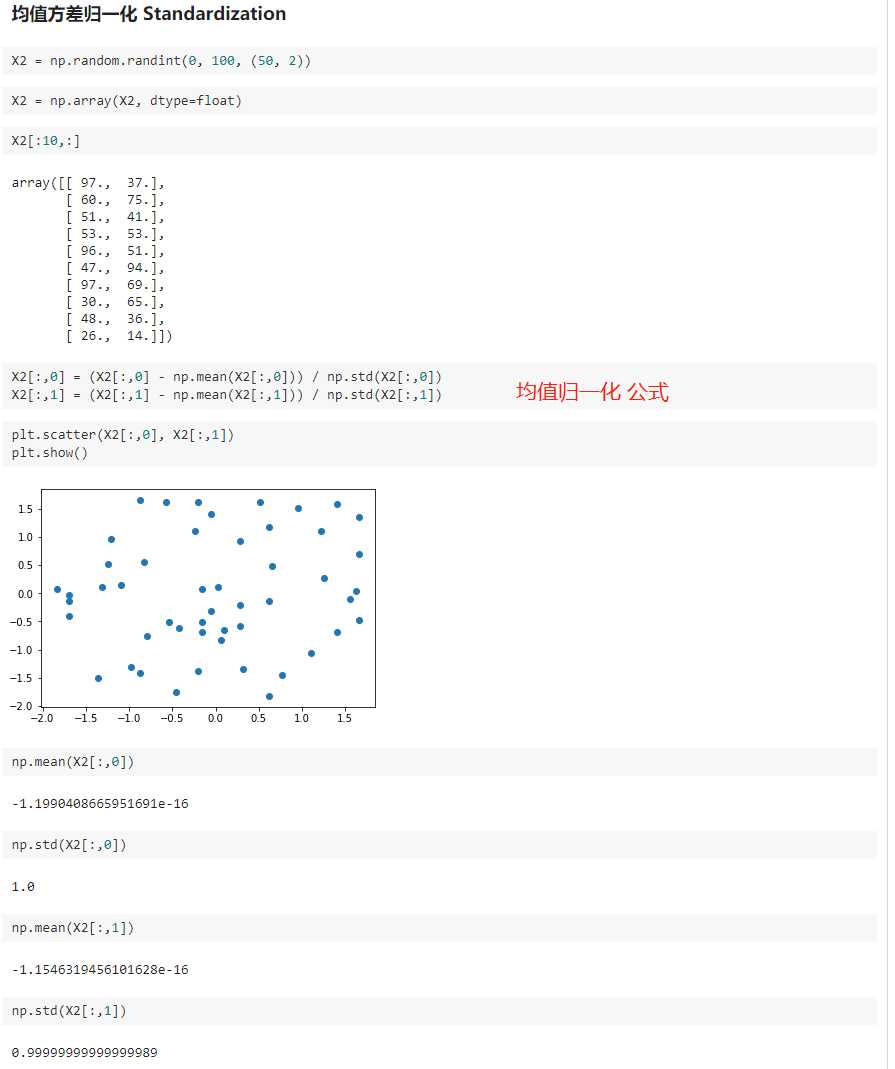

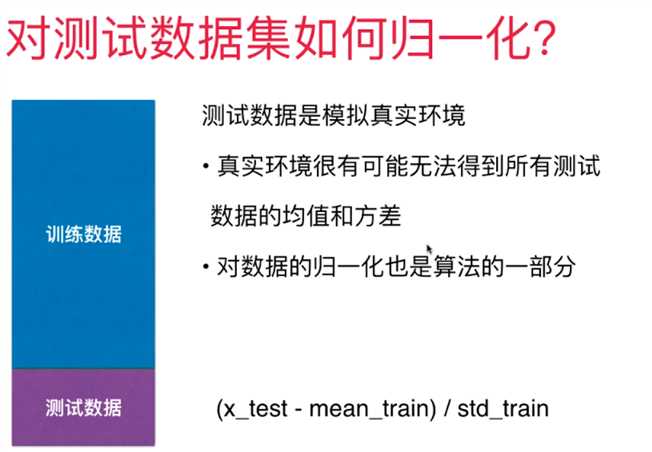

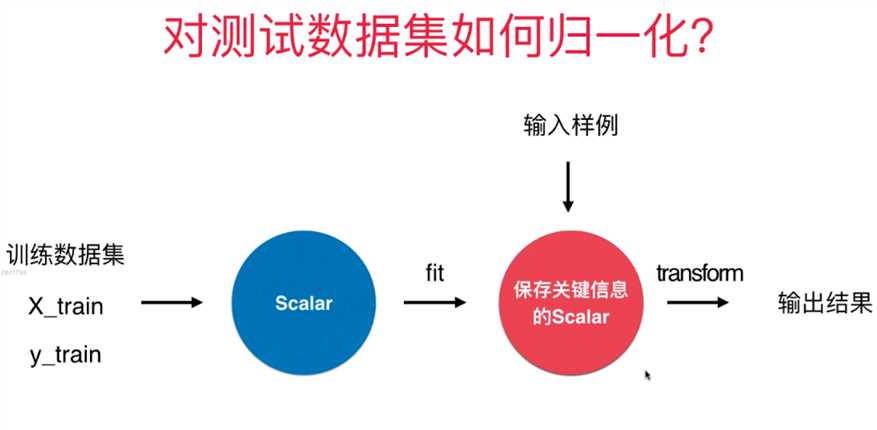

七、数据归一化 Feature Scaling

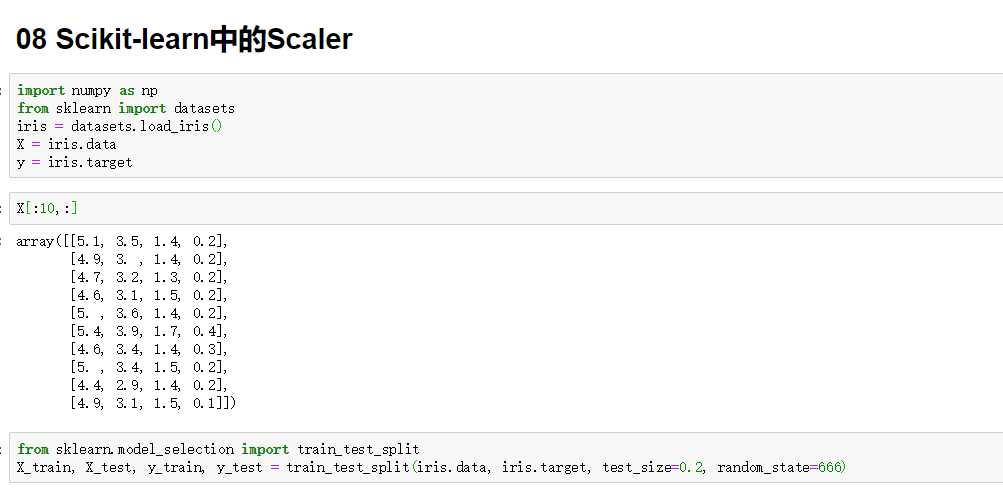

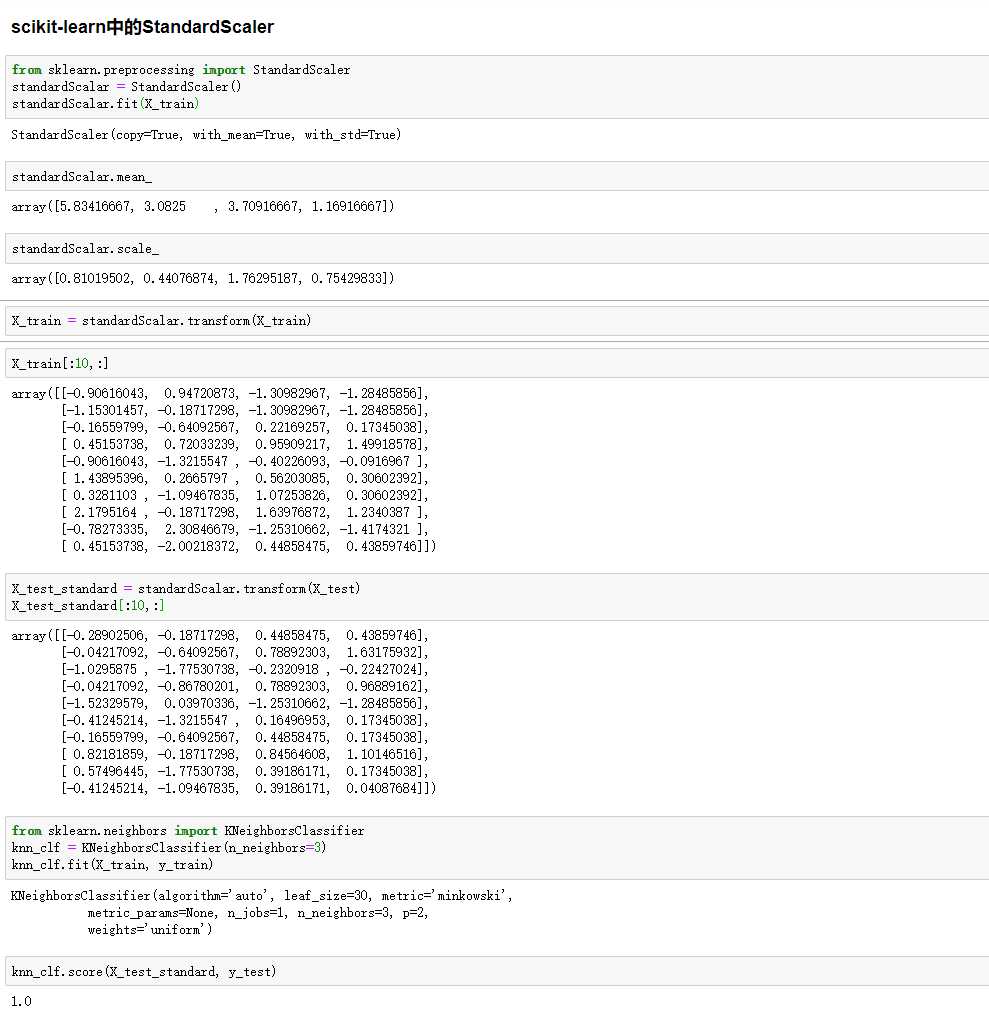

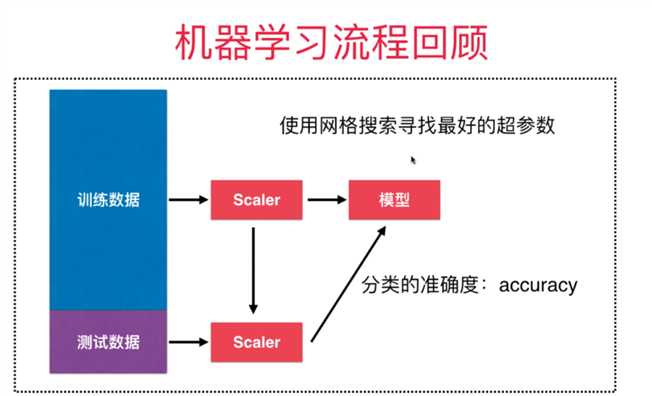

八、scikit-learn 中的 Scaler

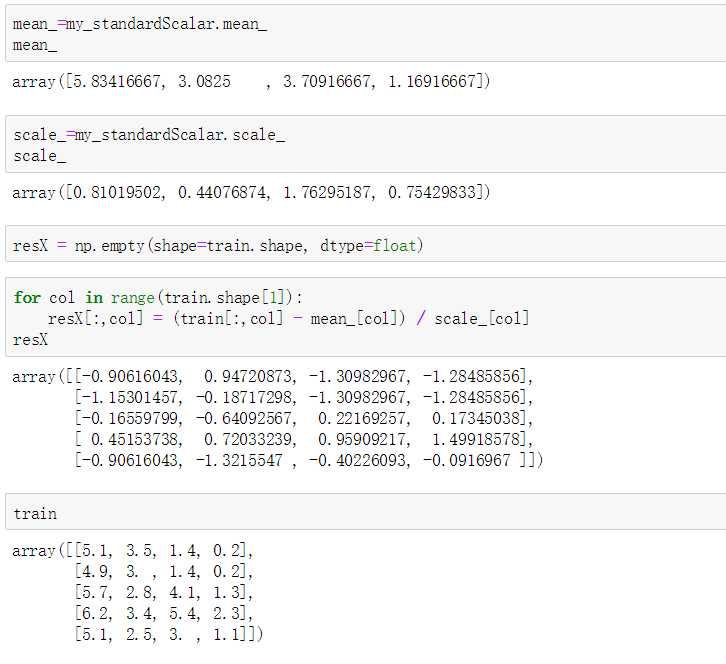

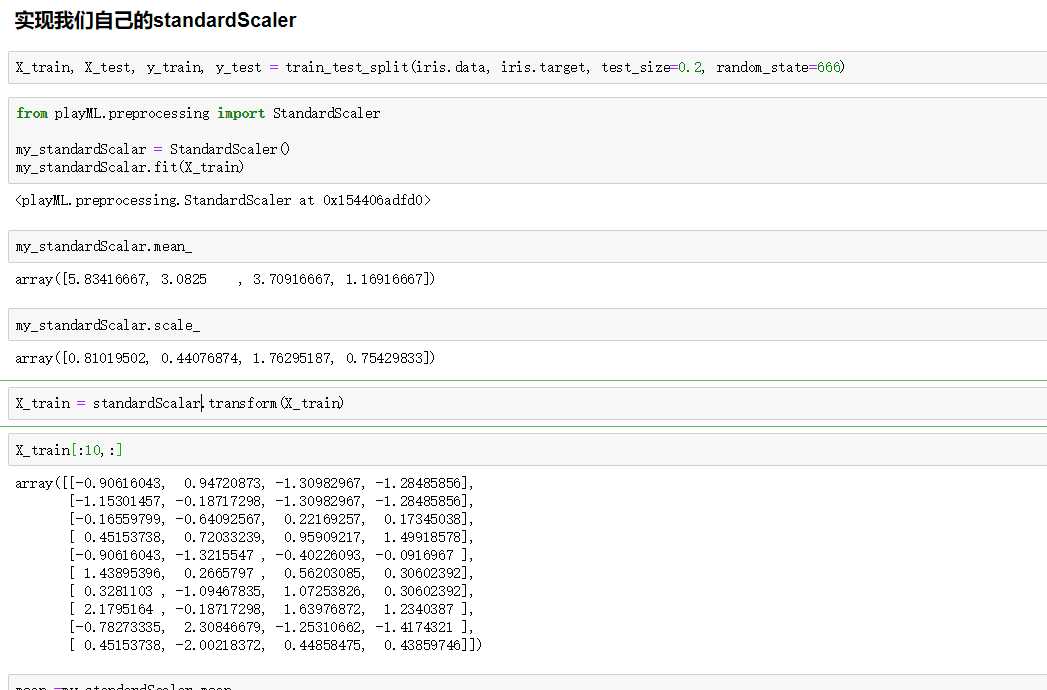

import numpy as np

class StandardScaler:

def __init__(self):

self.mean_ = None

self.scale_ = None

def fit(self, X):

"""根据训练数据集X获得数据的均值和方差"""

assert X.ndim == 2, "The dimension of X must be 2"

self.mean_ = np.array([np.mean(X[:,i]) for i in range(X.shape[1])])

self.scale_ = np.array([np.std(X[:,i]) for i in range(X.shape[1])])

return self

def transform(self, X):

"""将X根据这个StandardScaler进行均值方差归一化处理"""

assert X.ndim == 2, "The dimension of X must be 2"

assert self.mean_ is not None and self.scale_ is not None, "must fit before transform!"

assert X.shape[1] == len(self.mean_), "the feature number of X must be equal to mean_ and std_"

resX = np.empty(shape=X.shape, dtype=float)

for col in range(X.shape[1]):

resX[:,col] = (X[:,col] - self.mean_[col]) / self.scale_[col]

return resX

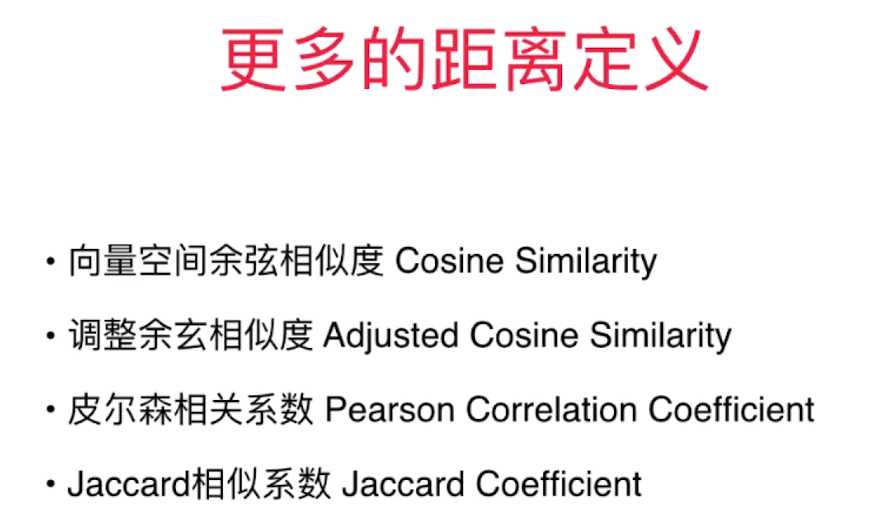

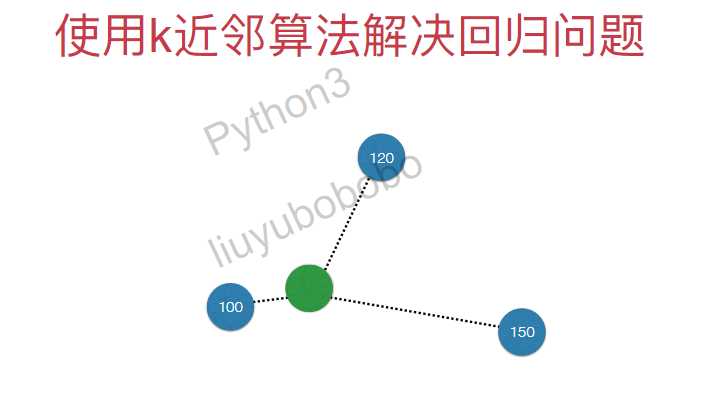

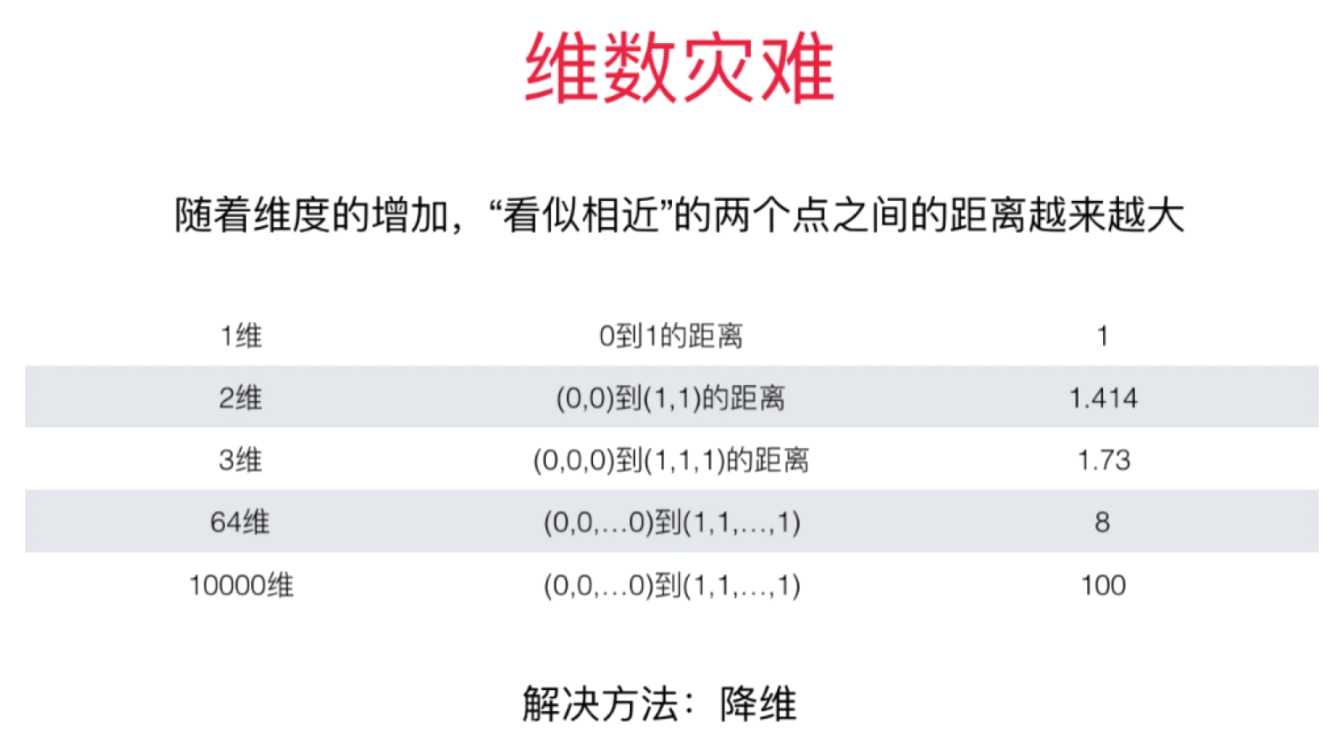

九、更多有关 K 近邻算法的思考

文章标题:机器学习(四) 机器学习(四) 分类算法--K近邻算法 KNN (下)

文章链接:http://soscw.com/index.php/essay/105876.html