【Spark机器学习速成宝典】基础篇01Windows下spark开发环境搭建+sbt+idea(Scala版)

2021-02-13 14:18

标签:def water rdd inpu app tar jar包 ide net spark用2.1.1 scala用2.11.11 以Scala书写的WordCount为例 【Spark机器学习速成宝典】基础篇01Windows下spark开发环境搭建+sbt+idea(Scala版) 标签:def water rdd inpu app tar jar包 ide net 原文地址:https://www.cnblogs.com/itmorn/p/8459938.html 注意:

材料准备

(注:spark2.1.0环境于scala2.11环境开发,所以必须版本对应

scala不是必须安装的,如果你是打算使用scala进行spark开发,则需要安装环境搭建步骤

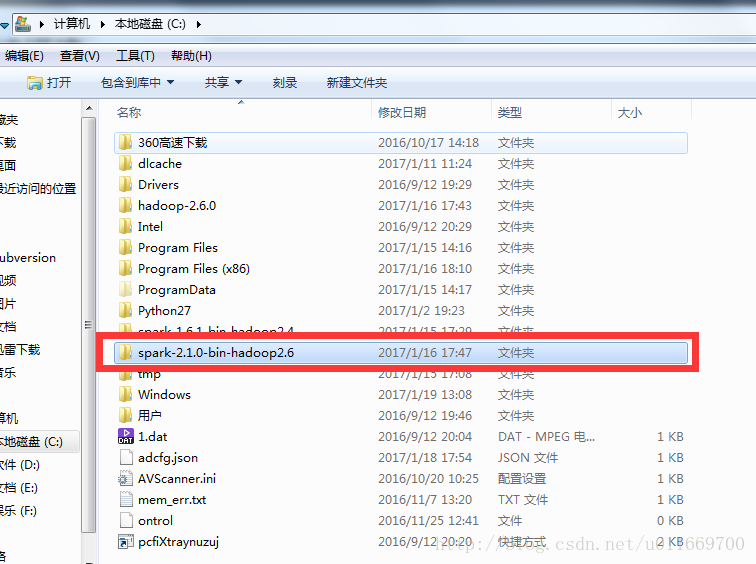

将spark-2.1.1-bin-hadoop2.x版本至c盘下即可

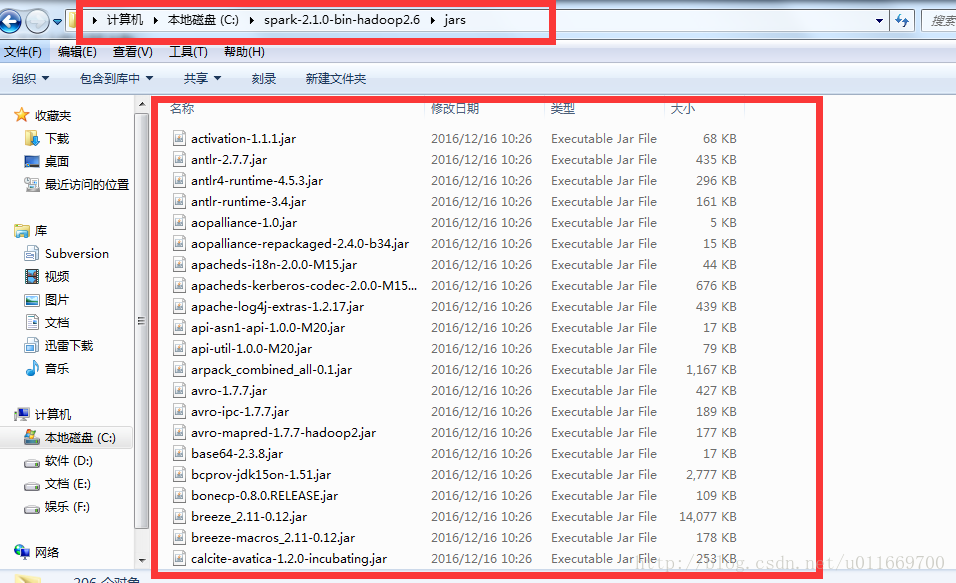

将spark中的jar包全部提取出来另外放到一地方用于进行开发

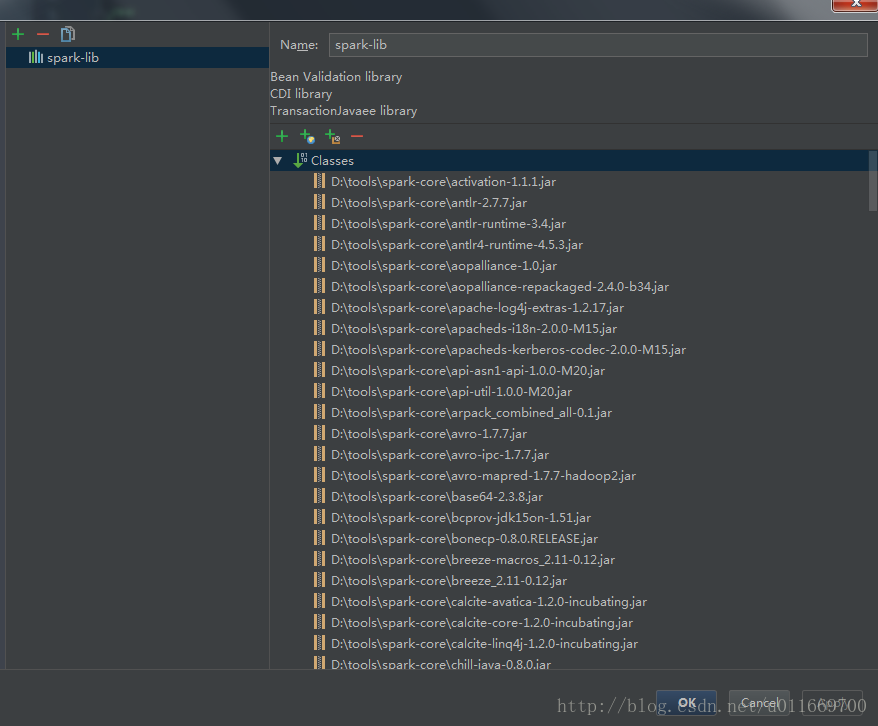

新建IDEA项目,将所有jar包导入到IDEA工程当中

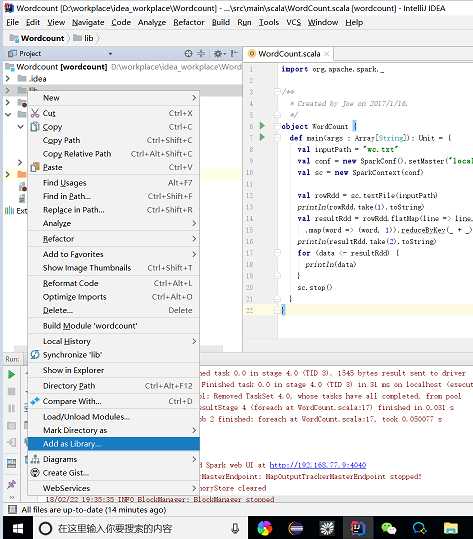

书写相应代码运行即可成功

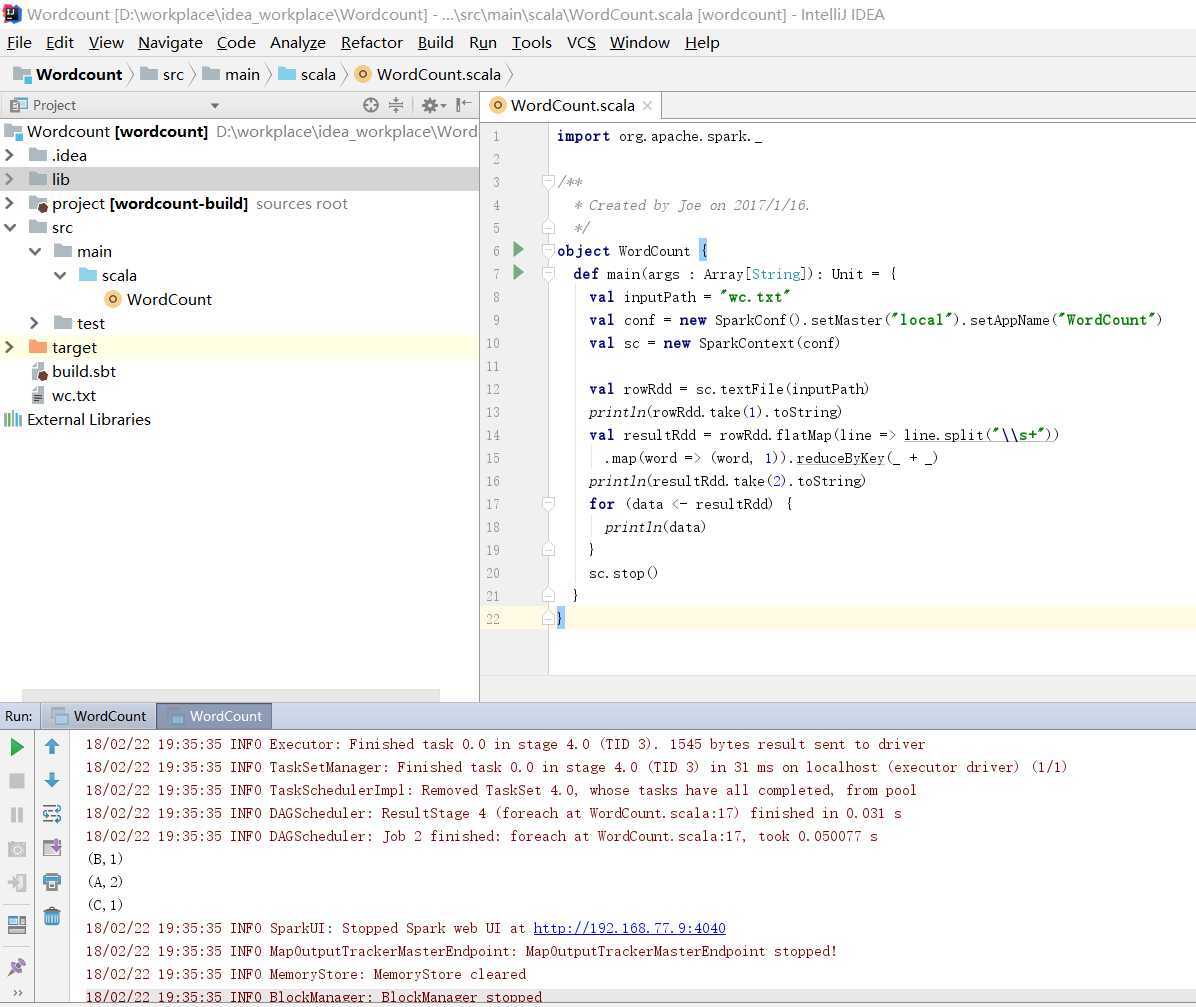

import org.apache.spark._

/**

* Created by Joe on 2017/1/16.

*/

object WordCount {

def main(args : Array[String]): Unit = {

val inputPath = "wc.txt"

val conf = new SparkConf().setMaster("local").setAppName("WordCount")

val sc = new SparkContext(conf)

val rowRdd = sc.textFile(inputPath)

println(rowRdd.take(1).toString)

val resultRdd = rowRdd.flatMap(line => line.split("\\s+"))

.map(word => (word, 1)).reduceByKey(_ + _)

println(resultRdd.take(2).toString)

for (data resultRdd) {

println(data)

}

sc.stop()

}

}

文章标题:【Spark机器学习速成宝典】基础篇01Windows下spark开发环境搭建+sbt+idea(Scala版)

文章链接:http://soscw.com/index.php/essay/54870.html