机器学习进度06(朴素贝叶斯算法、决策树、随机森林)

2021-03-06 05:27

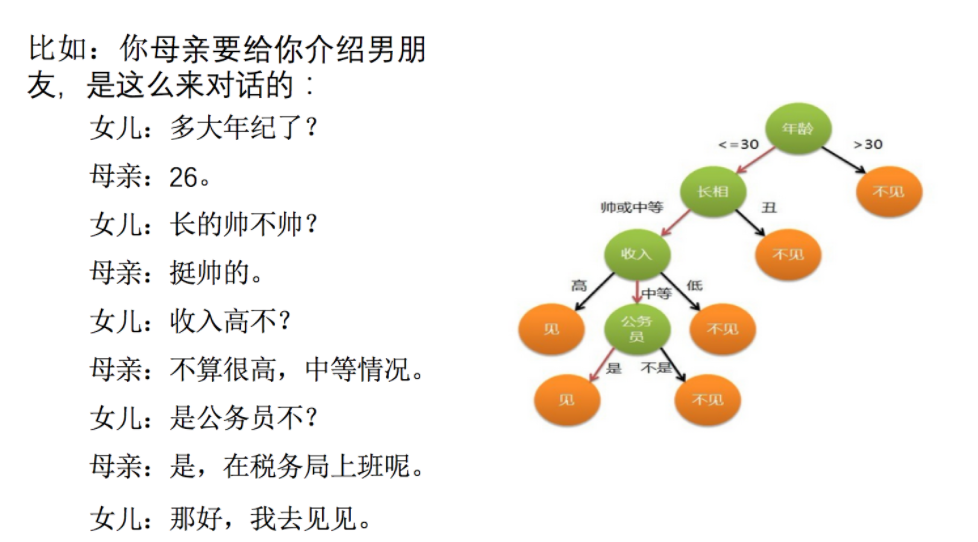

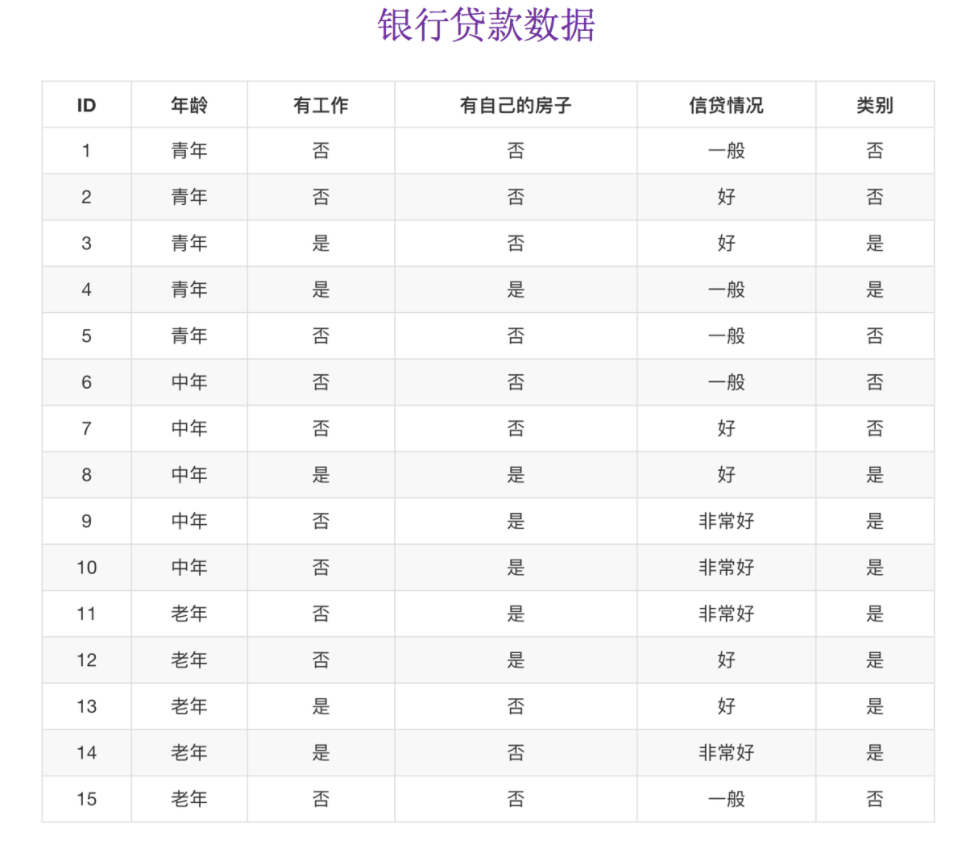

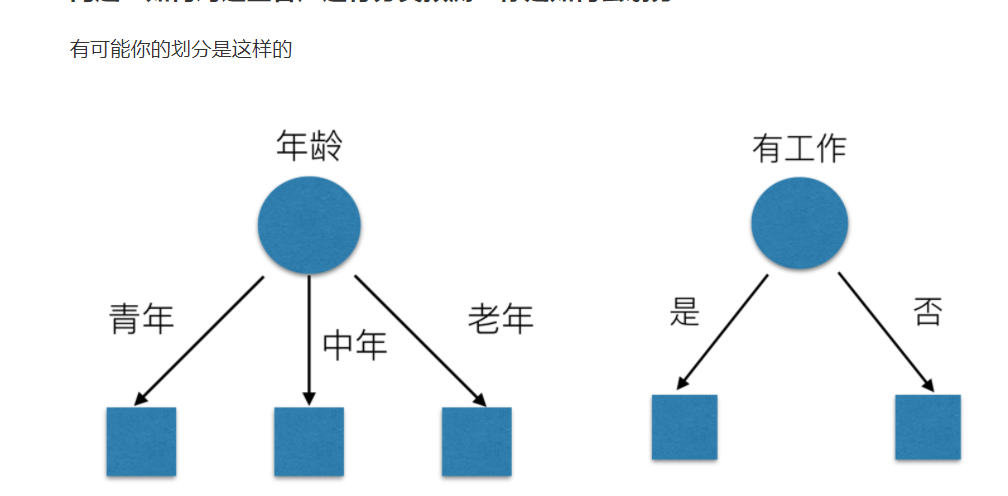

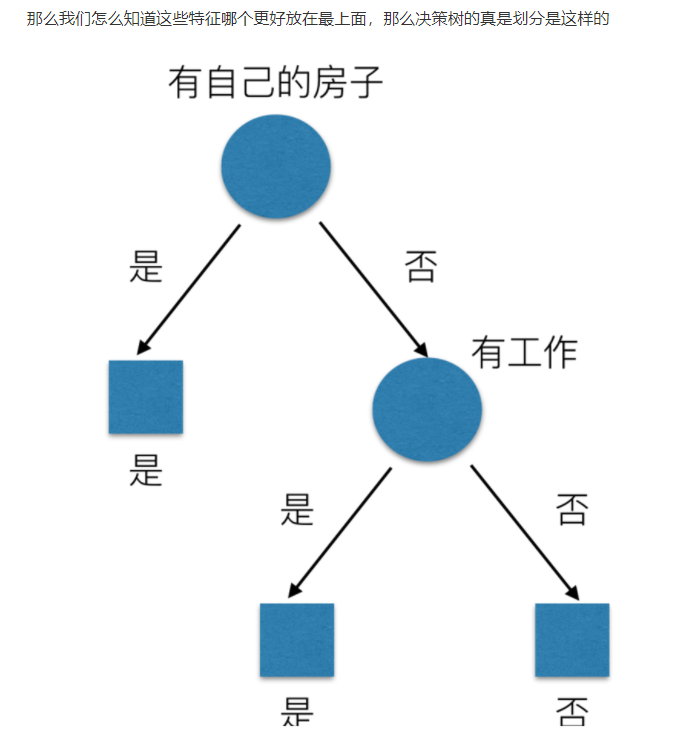

标签:param max etc 数据集 log res 节点 otp 获取 注意:此条件概率的成立,是由于A1,A2相互独立的结果(记忆) 决策树思想的来源非常朴素,程序设计中的条件分支结构就是if-then结构,最早的决策树就是利用这类结构分割数据的一种分类学习方法 总结(重要) 当我们得到的额外信息(球队历史比赛情况等等)越多的话,那么我们猜测的代价越小(猜测的不确定性减小) 特征A对训练数据集D的信息增益g(D,A),定义为集合D的信息熵H(D)与特征A给定条件下D的信息条件熵H(D|A)之差,即公式为: 当然决策树的原理不止信息增益这一种,还有其他方法。但是原理都类似,我们就不去举例计算。 上边写过代码: 数据来源和说明:https://www.kaggle.com/zephyrzhan522/titanic-prediction-dl-vs-ml 集成学习通过建立几个模型组合的来解决单一预测问题。它的工作原理是生成多个分类器/模型,各自独立地学习和作出预测。这些预测最后结合成组合预测,因此优于任何一个单分类的做出预测。 在机器学习中,随机森林是一个包含多个决策树的分类器,并且其输出的类别是由个别树输出的类别的众数而定。 例如, 如果你训练了5个树, 其中有4个树的结果是True, 1个数的结果是False, 那么最终投票结果就是True。 学习算法根据下列算法而建造每棵树: 机器学习进度06(朴素贝叶斯算法、决策树、随机森林) 标签:param max etc 数据集 log res 节点 otp 获取 原文地址:https://www.cnblogs.com/dazhi151/p/14305428.html朴素贝叶斯算法

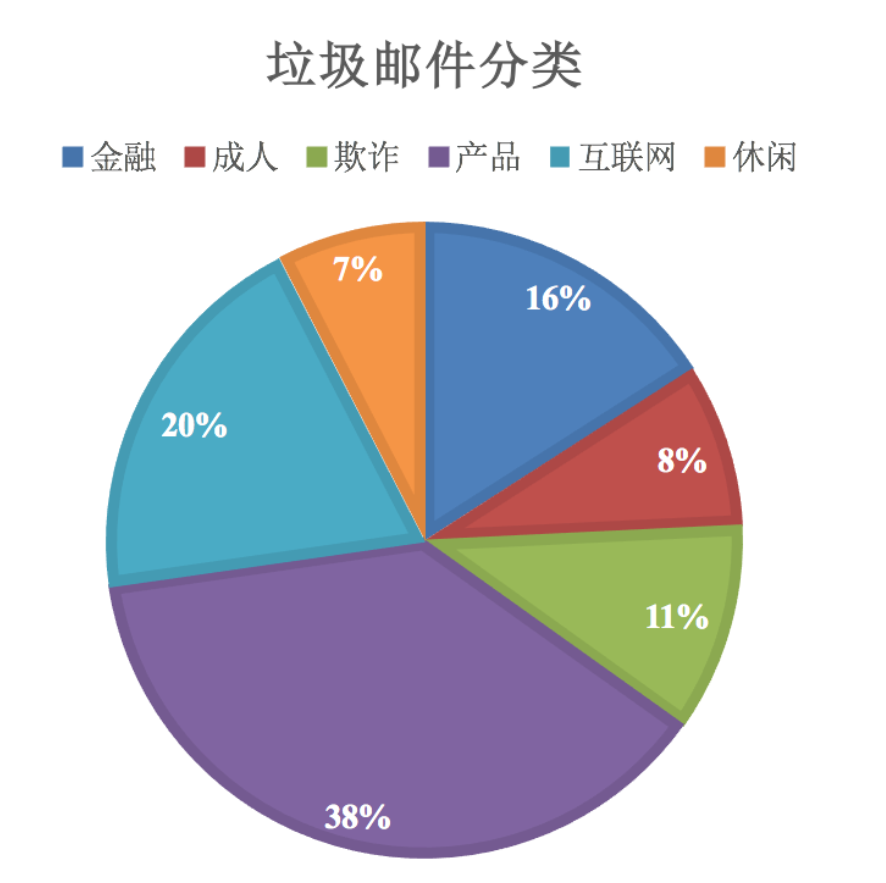

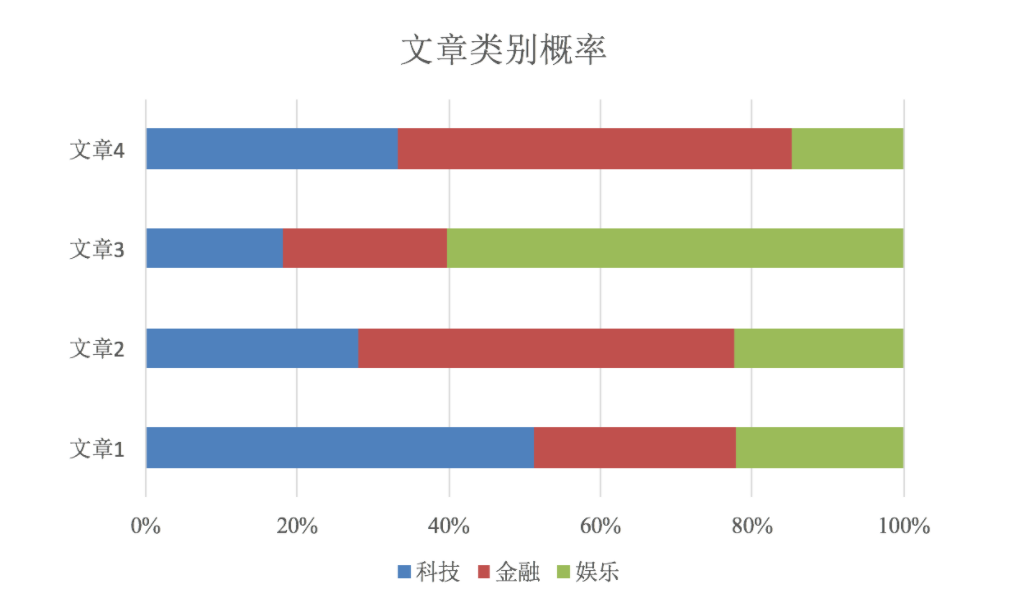

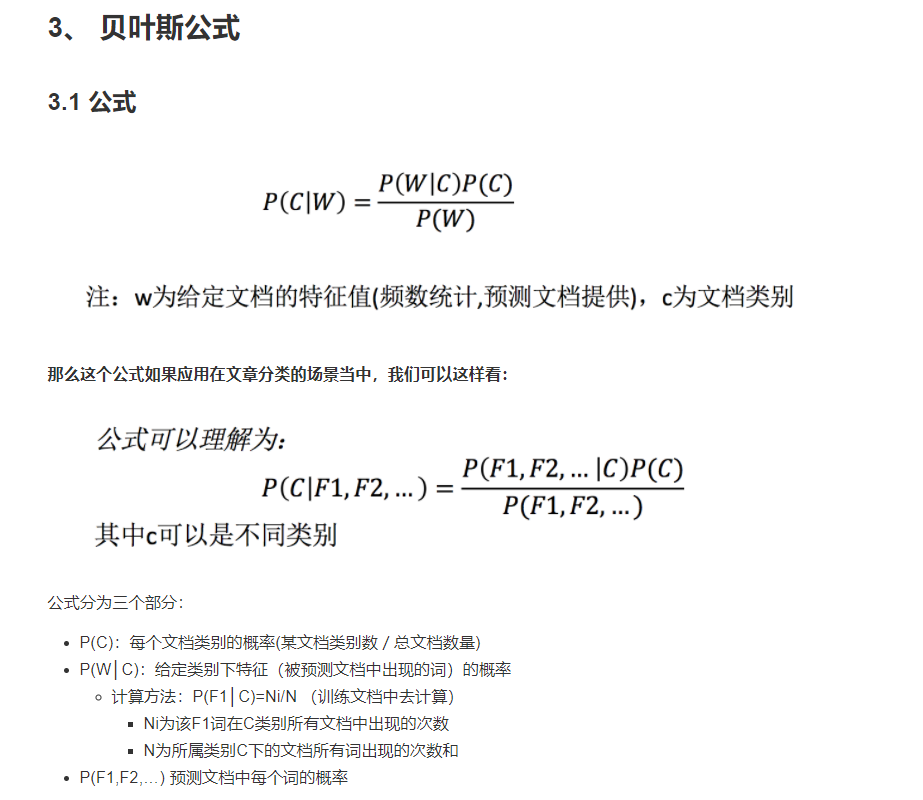

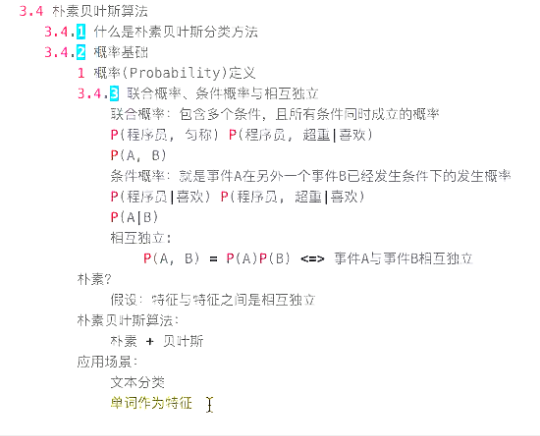

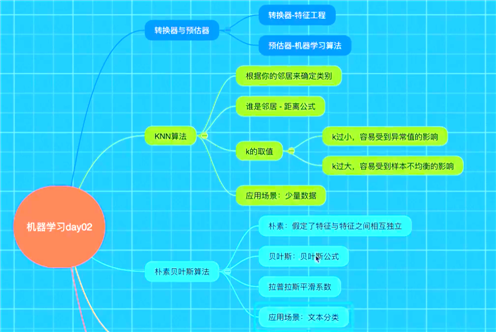

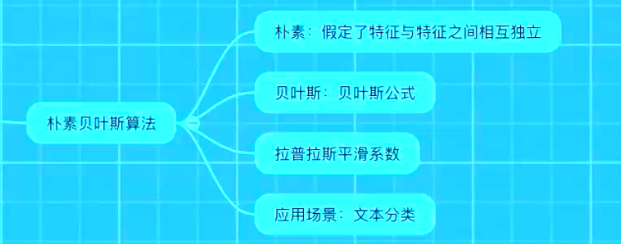

什么是朴素贝叶斯分类方法

条件概率与联合概率

API

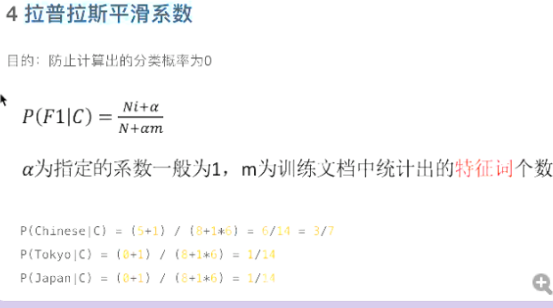

sklearn.naive_bayes.MultinomialNB(alpha = 1.0)

朴素贝叶斯分类

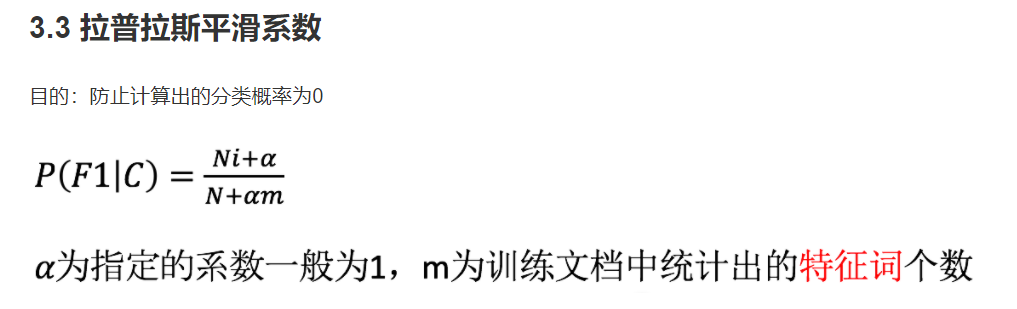

alpha:拉普拉斯平滑系数

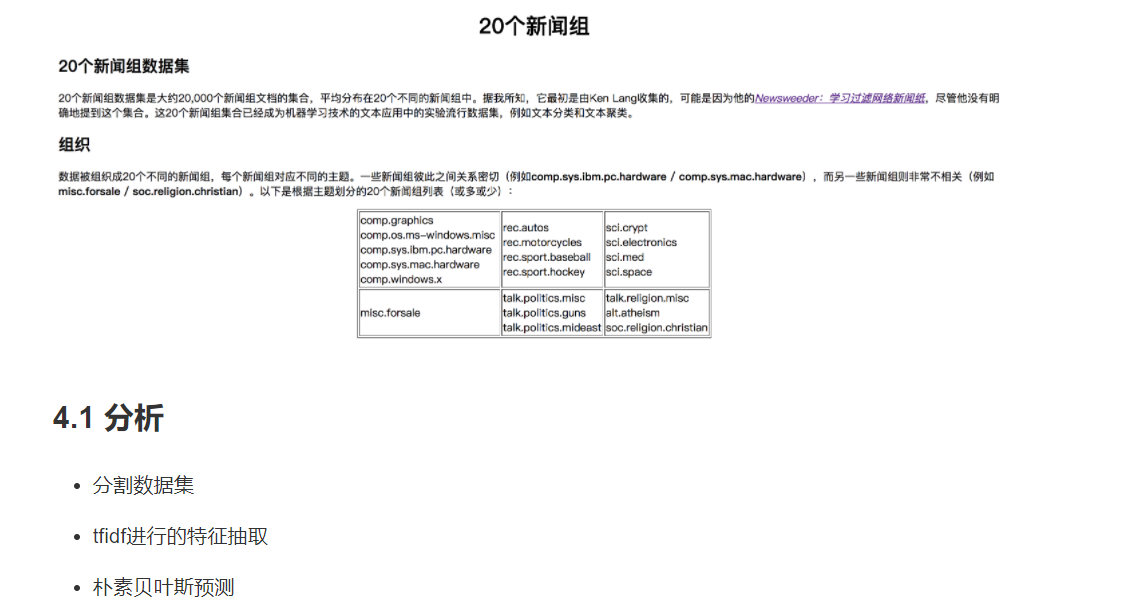

案例:20类新闻分类

代码:

#案例:20类新闻分类

def nb_news():

"""

用朴素贝叶斯算法对新闻进行分类

:return:

"""

# 1)获取数据

news = fetch_20newsgroups(subset="all")

# 2)划分数据集

x_train, x_test, y_train, y_test = train_test_split(news.data, news.target)

# 3)特征工程:文本特征抽取-tfidf

transfer = TfidfVectorizer()

x_train = transfer.fit_transform(x_train)

x_test = transfer.transform(x_test)

# 4)朴素贝叶斯算法预估器流程

estimator = MultinomialNB()

estimator.fit(x_train, y_train)

# 5)模型评估

# 方法1:直接比对真实值和预测值

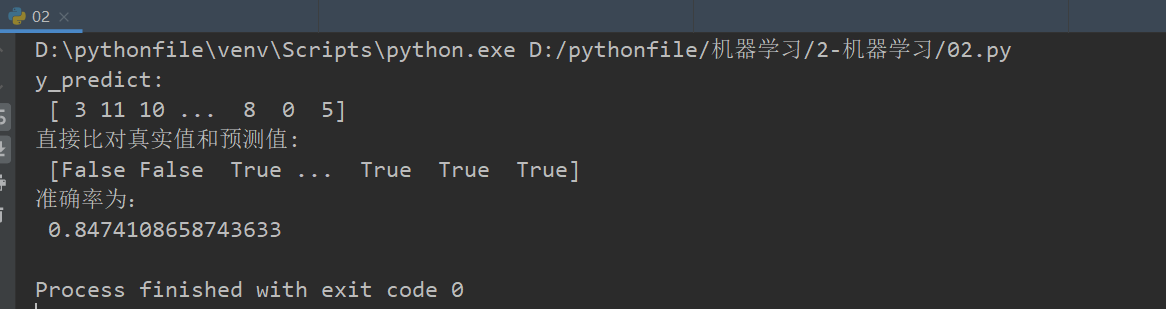

y_predict = estimator.predict(x_test)

print("y_predict:\n", y_predict)

print("直接比对真实值和预测值:\n", y_test == y_predict)

# 方法2:计算准确率

score = estimator.score(x_test, y_test)

print("准确率为:\n", score)

return None

if __name__=="__main__":

nb_news()

总结

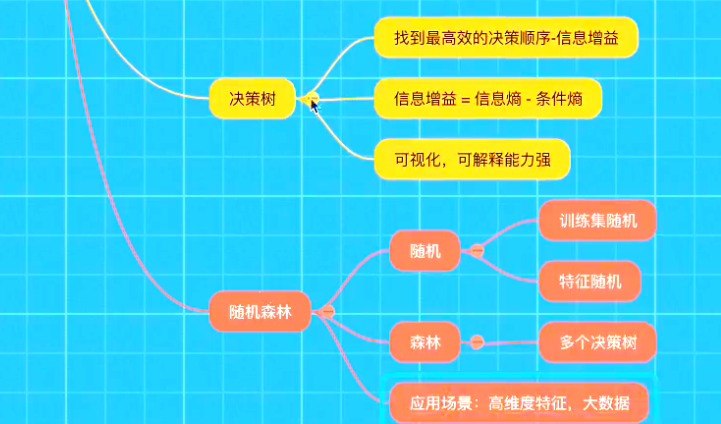

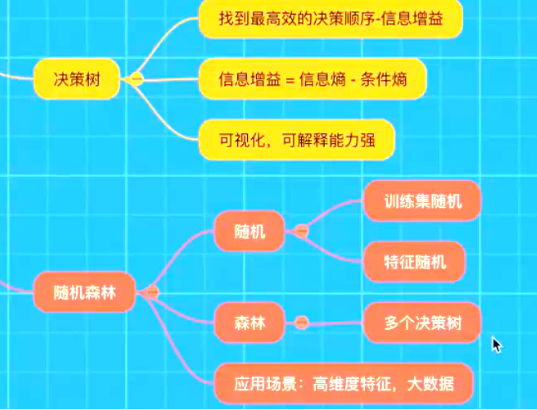

决策树

认识决策树

决策树分类原理详解

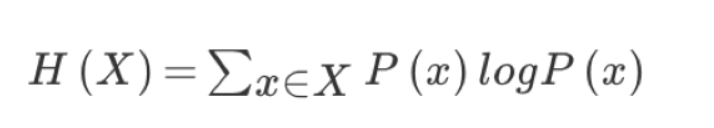

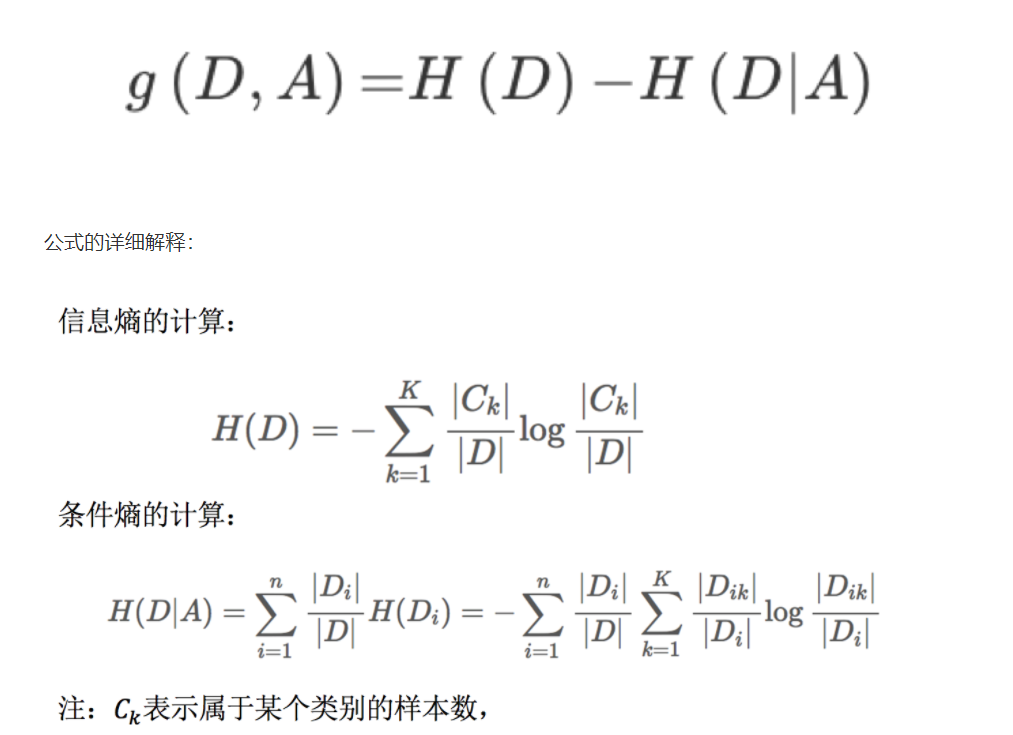

信息熵的定义

决策树的划分依据之一------信息增益

定义与公式

决策树的三种算法实现

决策树API

class sklearn.tree.DecisionTreeClassifier(criterion=’gini’, max_depth=None,random_state=None)

决策树分类器

criterion:默认是’gini’系数,也可以选择信息增益的熵’entropy’

max_depth:树的深度大小

random_state:随机数种子

其中会有些超参数:max_depth:树的深度大小

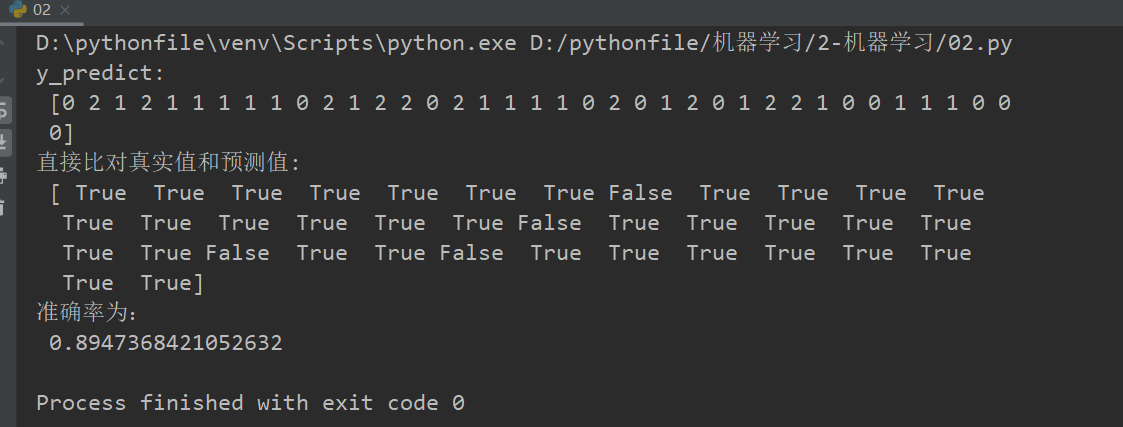

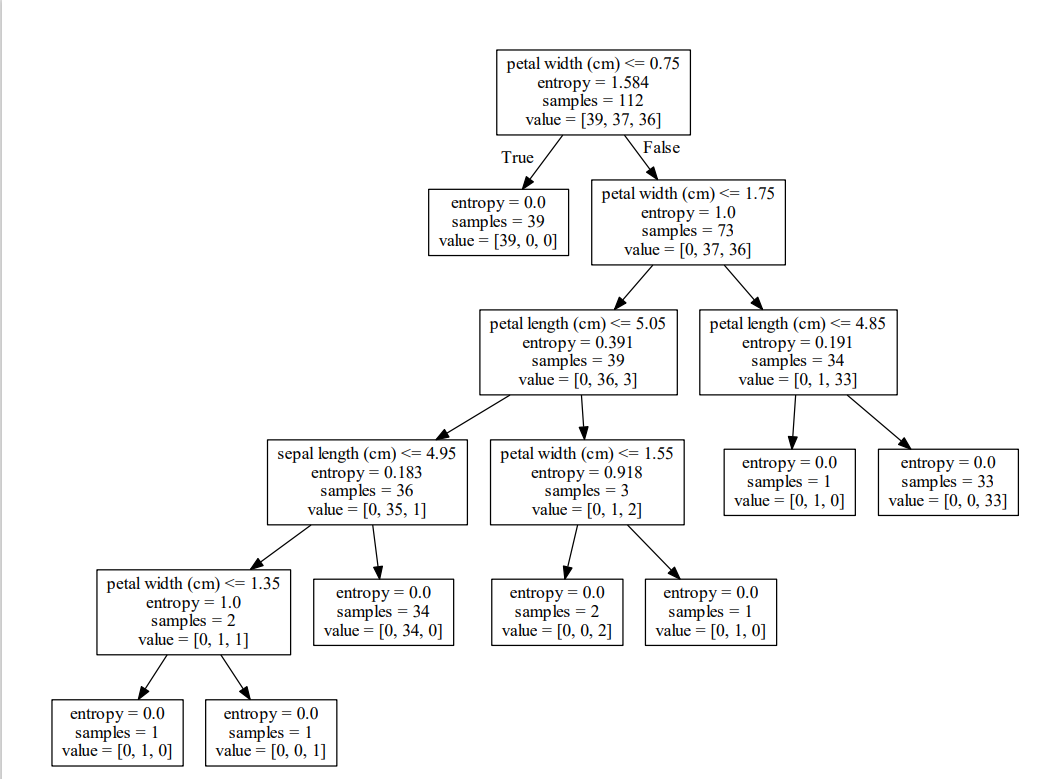

案例:用决策树对鸢尾花进行分类

#用决策树对鸢尾花进行分类

def decision_iris():

"""

用决策树对鸢尾花进行分类

:return:

"""

# 1)获取数据集

iris = load_iris()

# 2)划分数据集

x_train, x_test, y_train, y_test = train_test_split(iris.data, iris.target, random_state=22)

# 3)决策树预估器

estimator = DecisionTreeClassifier(criterion="entropy")

estimator.fit(x_train, y_train)

# 4)模型评估

# 方法1:直接比对真实值和预测值

y_predict = estimator.predict(x_test)

print("y_predict:\n", y_predict)

print("直接比对真实值和预测值:\n", y_test == y_predict)

# 方法2:计算准确率

score = estimator.score(x_test, y_test)

print("准确率为:\n", score)

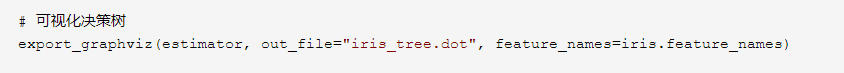

# 可视化决策树

#export_graphviz(estimator, out_file="iris_tree.dot", feature_names=iris.feature_names)

dot_data = export_graphviz(estimator, out_file=None, feature_names=iris.feature_names)

graph = pydotplus.graph_from_dot_data(dot_data)

graph.write_pdf("iris.pdf")return None if __name__=="__main__": decision_iris()

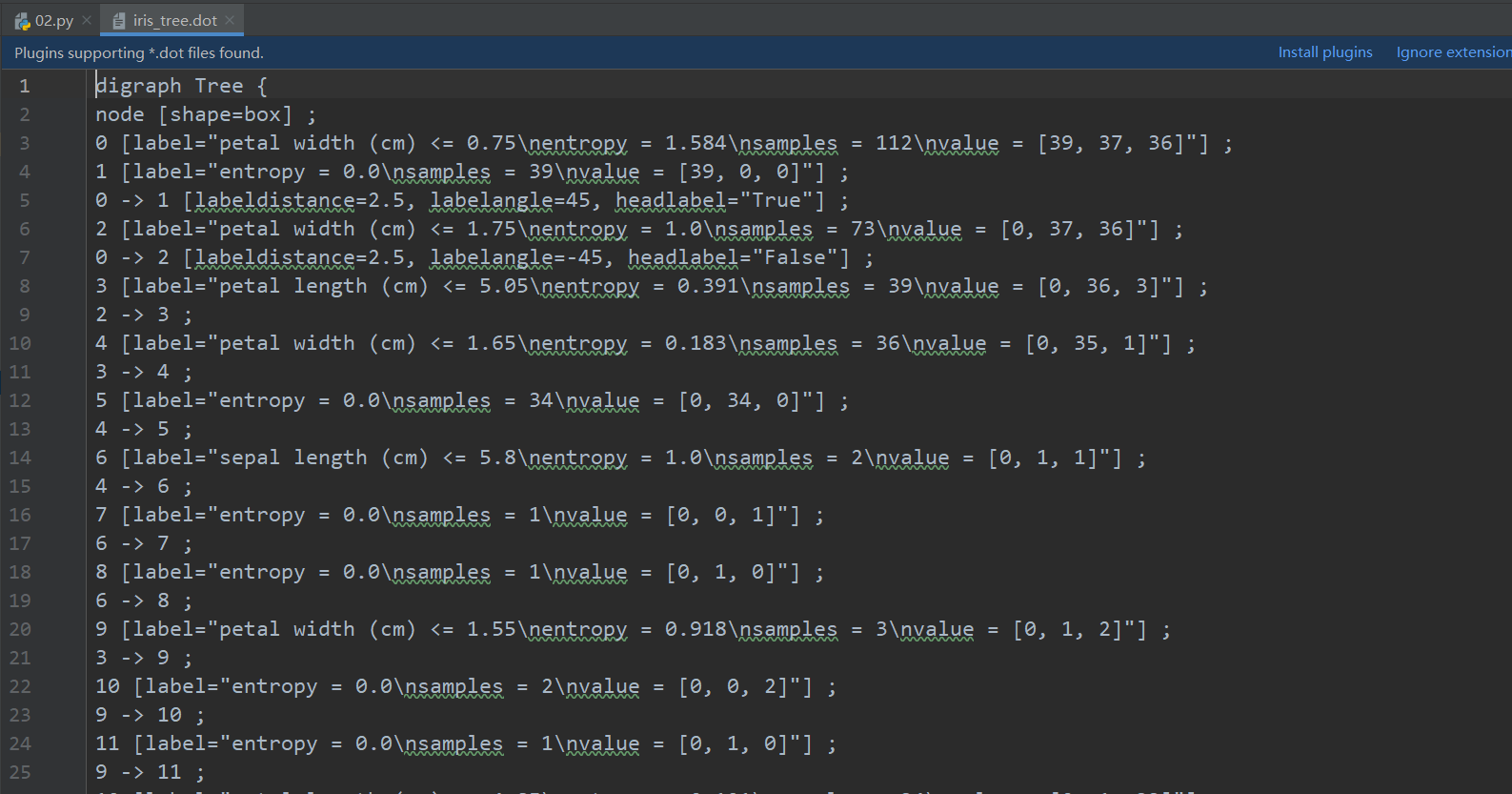

保存树的结构到dot文件

1、sklearn.tree.export_graphviz() 该函数能够导出DOT格式

tree.export_graphviz(estimator,out_file=‘tree.dot’,feature_names=[‘’,’’])

2、工具:(能够将dot文件转换为pdf、png)

安装graphviz

ubuntu:sudo apt-get install graphviz Mac:brew install graphviz

3、运行命令

然后我们运行这个命令

dot -Tpng tree.dot -o tree.png

总结

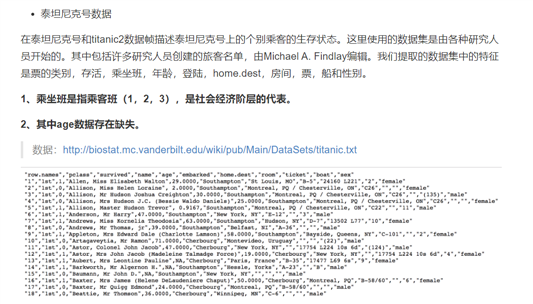

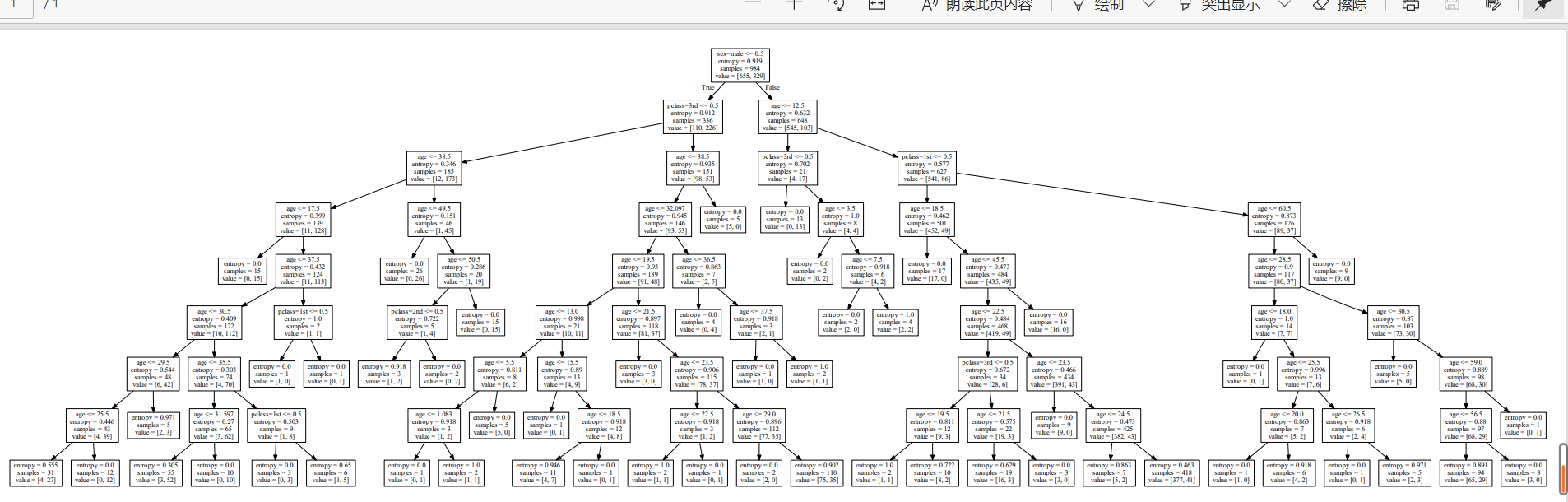

案例:泰坦尼克号乘客生存预测

分析

代码

#泰坦尼克号乘客生存预测

def titanic():

# 1、获取数据

path = "titanic.txt"

titanic = pd.read_csv(path)

# 筛选特征值和目标值

x = titanic[["pclass", "age", "sex"]]

y = titanic["survived"]

# 2、数据处理

# 1)缺失值处理

x["age"].fillna(x["age"].mean(), inplace=True) #填充平均值

# 2) 转换成字典

x = x.to_dict(orient="records")

# 3、数据集划分

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=22)

# 4、字典特征抽取

transfer = DictVectorizer()

x_train = transfer.fit_transform(x_train)

x_test = transfer.transform(x_test)

# 3)决策树预估器

estimator = DecisionTreeClassifier(criterion="entropy", max_depth=8)

estimator.fit(x_train, y_train)

# 4)模型评估

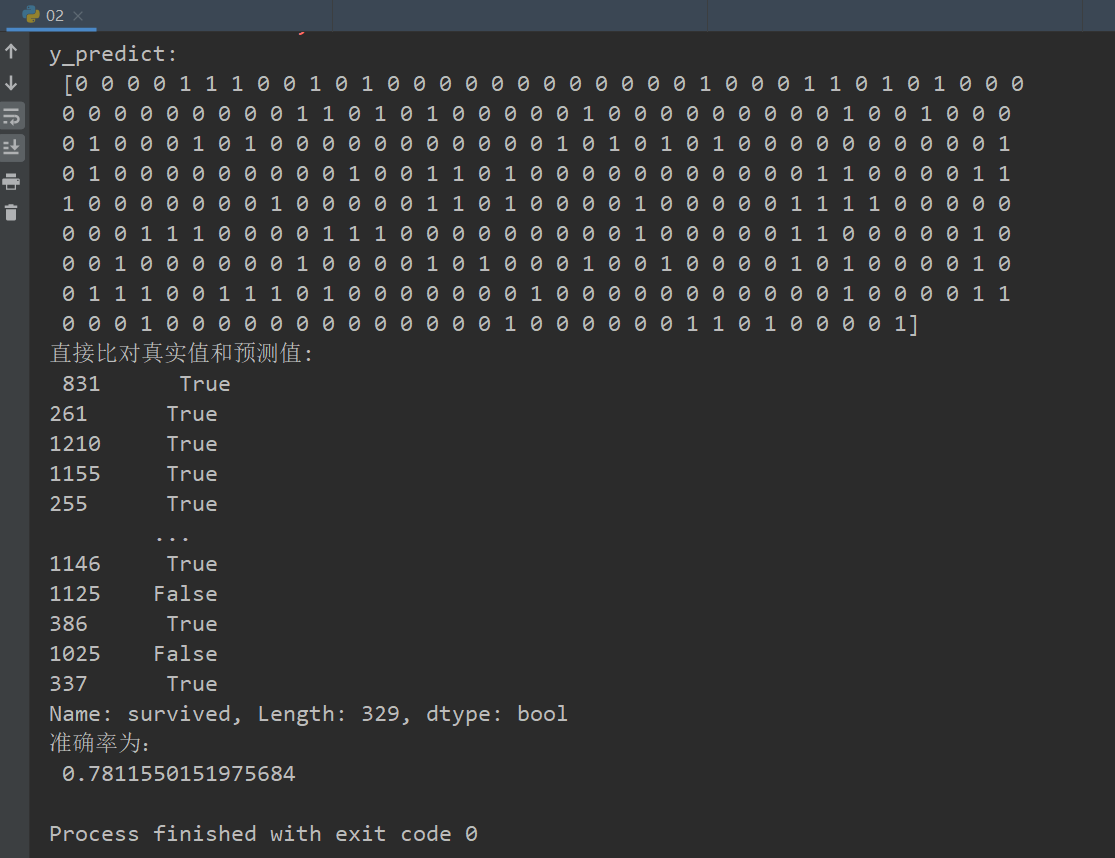

# 方法1:直接比对真实值和预测值

y_predict = estimator.predict(x_test)

print("y_predict:\n", y_predict)

print("直接比对真实值和预测值:\n", y_test == y_predict)

# 方法2:计算准确率

score = estimator.score(x_test, y_test)

print("准确率为:\n", score)

# 可视化决策树

dot_data =export_graphviz(estimator, out_file=None, feature_names=transfer.get_feature_names())

graph = pydotplus.graph_from_dot_data(dot_data)

graph.write_pdf("titanic.pdf")

if __name__=="__main__":

titanic()

随机森林

什么是集成学习方法

什么是随机森林

随机森林原理过程

为什么采用BootStrap抽样

API

class sklearn.ensemble.RandomForestClassifier(n_estimators=10, criterion=’gini’, max_depth=None, bootstrap=True, random_state=None, min_samples_split=2)

随机森林分类器

n_estimators:integer,optional(default = 10)森林里的树木数量120,200,300,500,800,1200

criteria:string,可选(default =“gini”)分割特征的测量方法

max_depth:integer或None,可选(默认=无)树的最大深度 5,8,15,25,30

max_features="auto”,每个决策树的最大特征数量

If "auto", then max_features=sqrt(n_features).

If "sqrt", then max_features=sqrt(n_features) (same as "auto").

If "log2", then max_features=log2(n_features).

If None, then max_features=n_features.

bootstrap:boolean,optional(default = True)是否在构建树时使用放回抽样

min_samples_split:节点划分最少样本数

min_samples_leaf:叶子节点的最小样本数

超参数:n_estimator, max_depth, min_samples_split,min_samples_leaf

代码:

#泰坦尼克号乘客生存预测随机森林

def suijisanli_demo():

# 1、获取数据

path = "titanic.csv"

titanic = pd.read_csv(path)

# 筛选特征值和目标值

x = titanic[["pclass", "age", "sex"]]

y = titanic["survived"]

# 2、数据处理

# 1)缺失值处理

x["age"].fillna(x["age"].mean(), inplace=True)

# 2) 转换成字典

x = x.to_dict(orient="records")

# 3、数据集划分

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=22)

# 4、字典特征抽取

transfer = DictVectorizer()

x_train = transfer.fit_transform(x_train)

x_test = transfer.transform(x_test)

#随机森林预估器

estimator = RandomForestClassifier()

# 加入网格搜索与交叉验证

# 参数准备

param_dict = {"n_estimators": [120, 200, 300, 500, 800, 1200], "max_depth": [5, 8, 15, 25, 30]}

estimator = GridSearchCV(estimator, param_grid=param_dict, cv=3)

estimator.fit(x_train, y_train)

# 5)模型评估

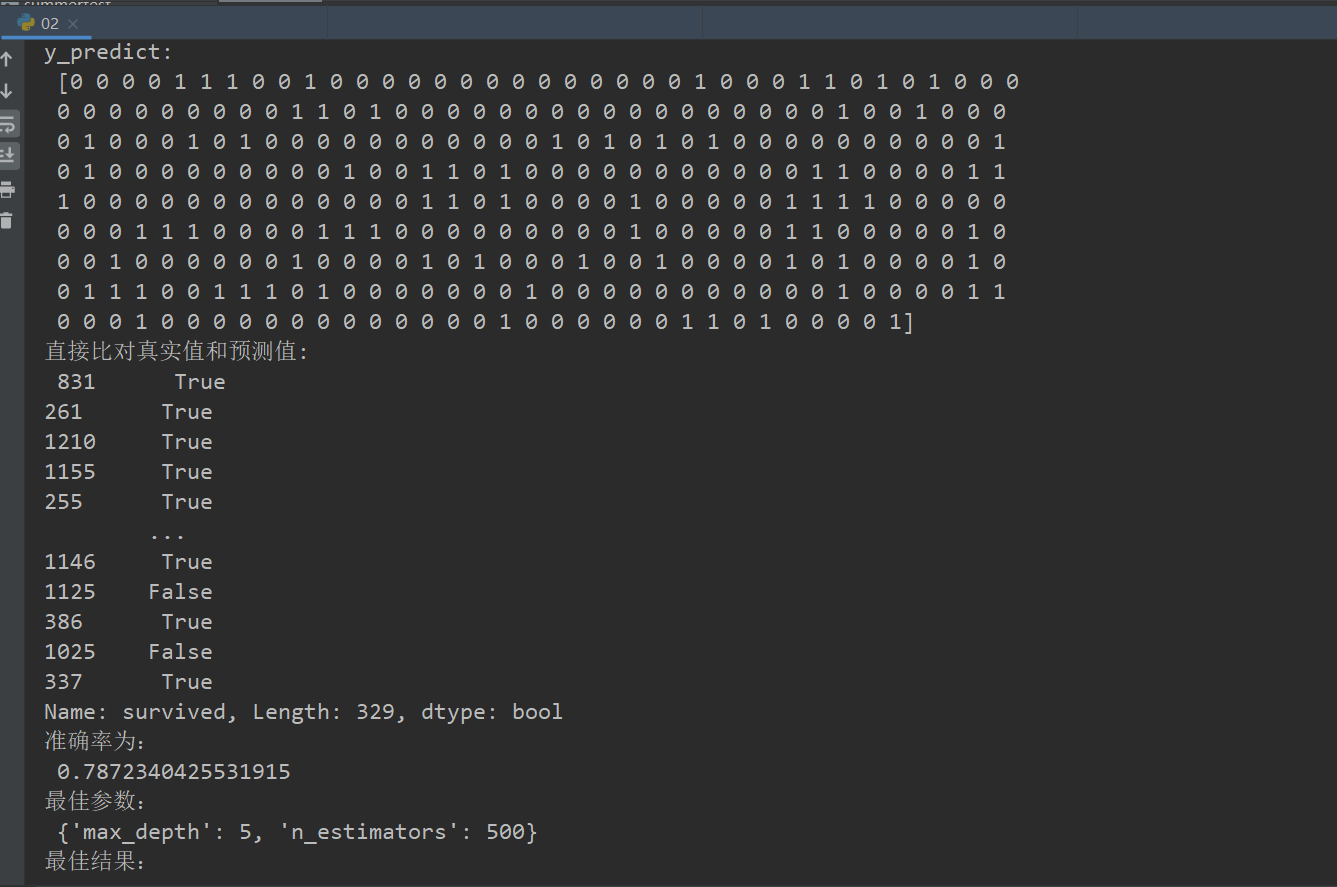

# 方法1:直接比对真实值和预测值

y_predict = estimator.predict(x_test)

print("y_predict:\n", y_predict)

print("直接比对真实值和预测值:\n", y_test == y_predict)

# 方法2:计算准确率

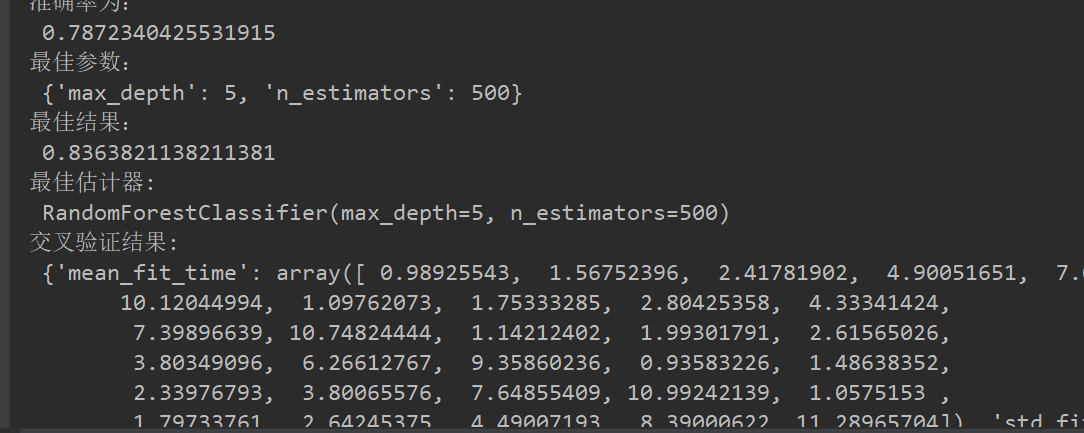

score = estimator.score(x_test, y_test)

print("准确率为:\n", score)

# 最佳参数:best_params_

print("最佳参数:\n", estimator.best_params_)

# 最佳结果:best_score_

print("最佳结果:\n", estimator.best_score_)

# 最佳估计器:best_estimator_

print("最佳估计器:\n", estimator.best_estimator_)

# 交叉验证结果:cv_results_

print("交叉验证结果:\n", estimator.cv_results_)

if __name__=="__main__":

suijisanli_demo()

总结

文章标题:机器学习进度06(朴素贝叶斯算法、决策树、随机森林)

文章链接:http://soscw.com/index.php/essay/60715.html