2020/02/26 CapsuleNet ( 胶囊网络 ) 的初认识

2021-04-14 10:26

标签:增加 ima inf 类别 str alt 解决 图片 区别 训练层面 原理层面 2020/02/26 CapsuleNet ( 胶囊网络 ) 的初认识 标签:增加 ima inf 类别 str alt 解决 图片 区别 原文地址:https://www.cnblogs.com/Research-XiaoEMo/p/12376305.html提出动机

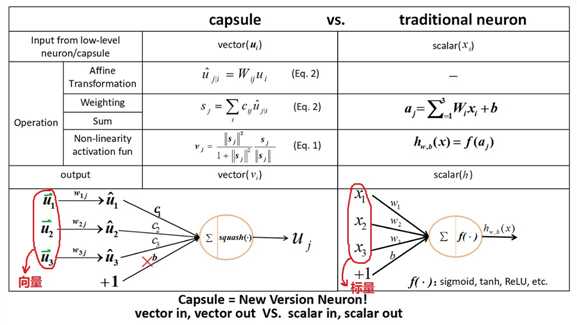

CNN与Capsule的区别

文章标题:2020/02/26 CapsuleNet ( 胶囊网络 ) 的初认识

文章链接:http://soscw.com/index.php/essay/75618.html