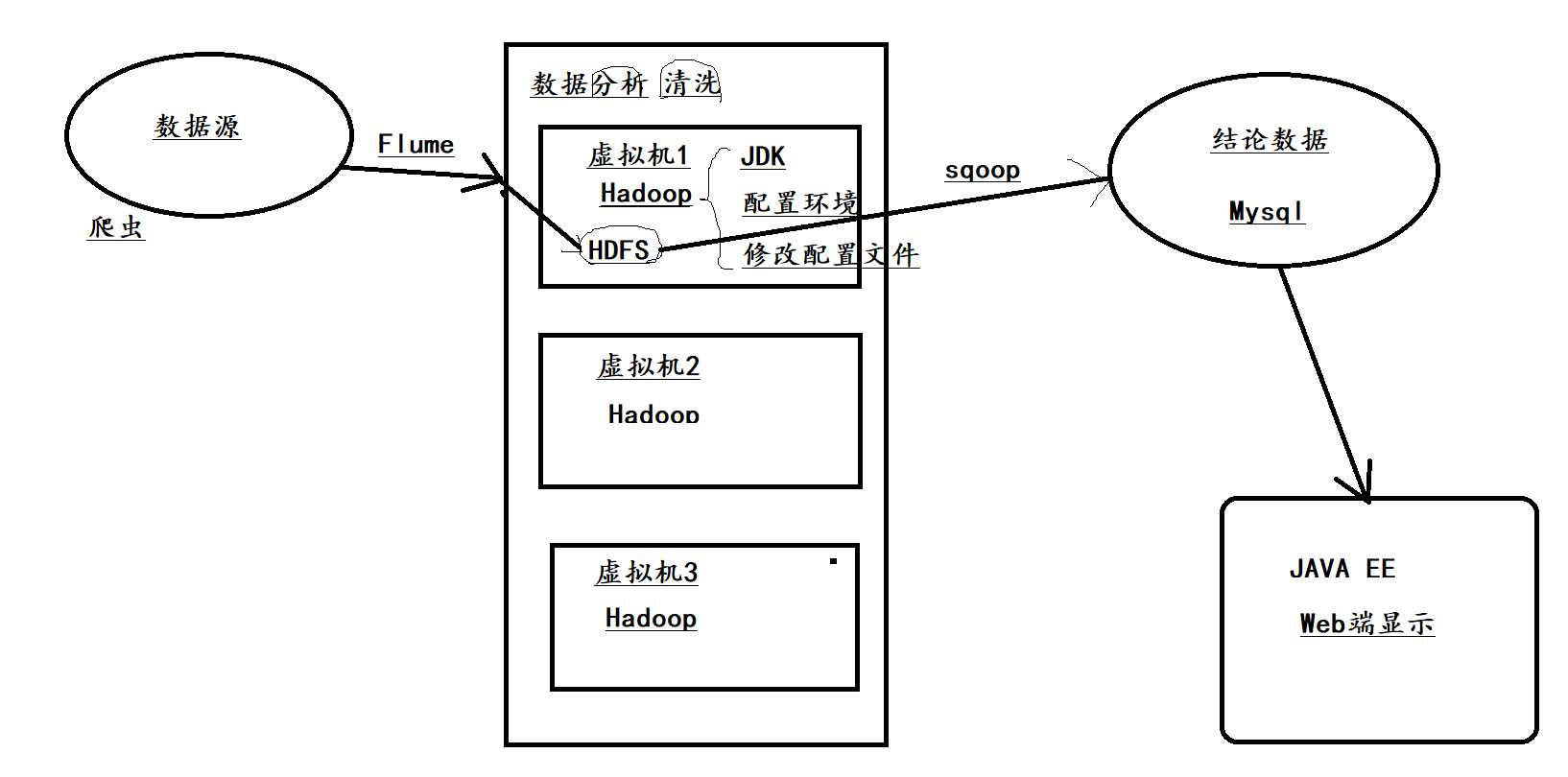

大数据开发:(三)flume上传HDFS

2021-06-04 01:02

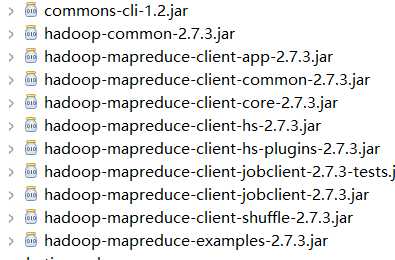

标签:inpu mys dem mysq jar 电影 -- let get 开启 通过浏览器访问node节点,http://IP:50070 检查 操作分布式文件存储系统HDFS 查看hdfs中的文件内容 查看hdfs中的详细内容 在HDFS中创建文件夹 Flume上传数据到HDFS中 解压flume 将flume文件下得conf中flume-env.ps1.template复制一份,改为flume-env.ps1 修改conf下得log4j.properties文件,在文件末尾修改,改后结果为:flume.root.logger=INFO,console 找到hadoop安装包,从安装包中找到相关jar包,放入到flume的lib下 下载hadoop-common-2.2.0bin-master ? HADOOP_HOME : ? Path: 给hdfs/flume权限(可以操作权限): Hadoop运行机制 查看数据片内容: Map reduce 所需要的jar包 大数据开发:(三)flume上传HDFS 标签:inpu mys dem mysq jar 电影 -- let get 原文地址:https://www.cnblogs.com/dreamzone/p/12344546.html

hadoop:start-dfs.sh

hadoop fs -ls /hadoop fs -ls /hadoop fs -mkdir /flume

E:\大数据学习\hadoop-common-2.2.0-bin-masterPath 配置路径%HADOOP_HOME%\bin %HADOOP_HOME%\sbinhadoop fs -chmod 777 /flume

hadoop fs -cat /flume/events-.1582198102809

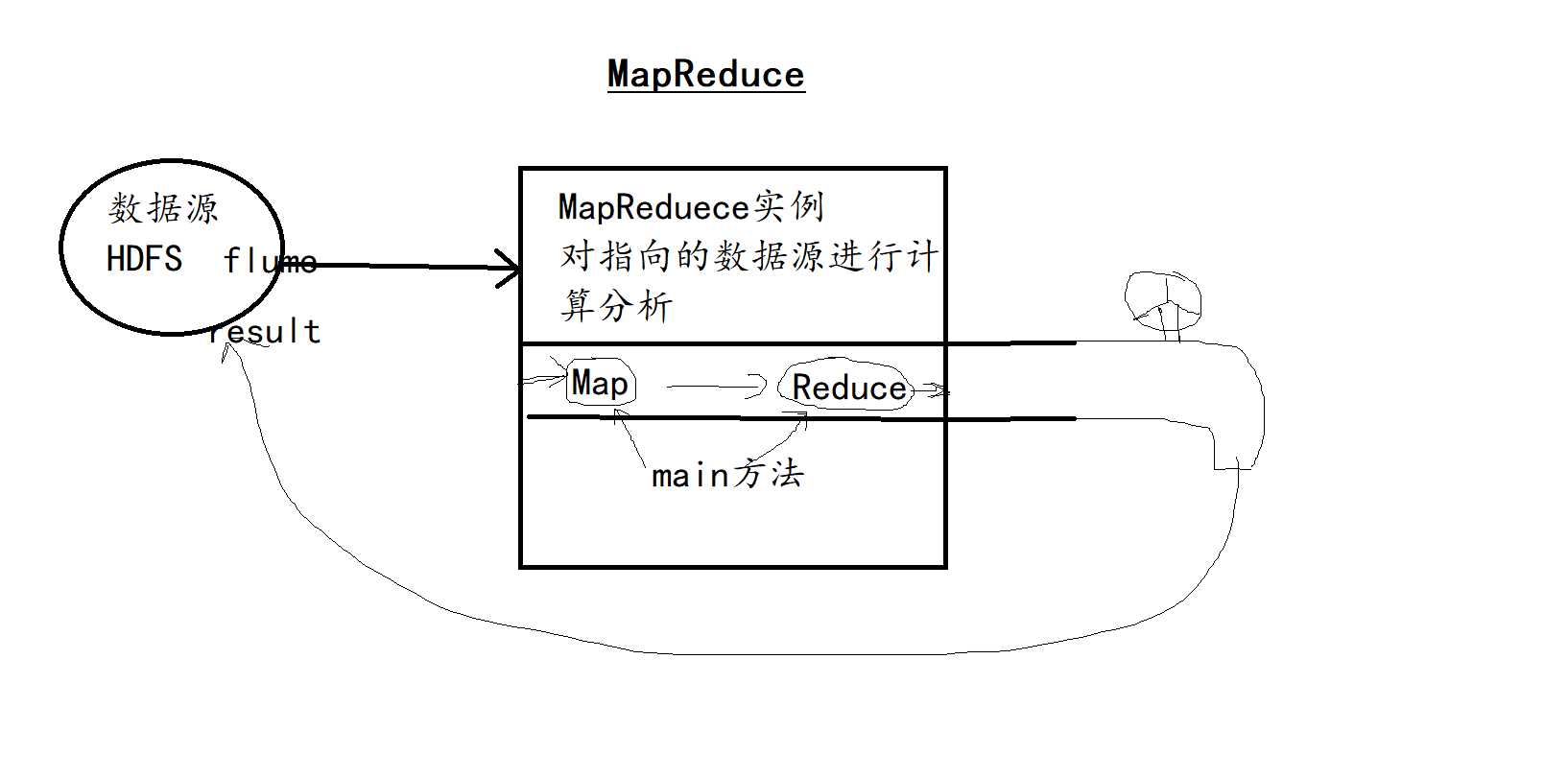

public static void main(String[] args) throws IOException, ClassNotFoundException, InterruptedException {

Configuration conf = new Configuration();

// 定义一个文件夹路径 用于存储计算分析后的可用数据

Path outputPath = new Path("hdfs://192.168.159.1:8020/flume/output");

//判断新路径是否已经存在

FileSystem fileSystem =FileSystem.get(conf);

if(fileSystem.exists(outputPath)) { //如果存在 先删除再创建

fileSystem.delete(outputPath,true);

}

Job job = Job.getInstance(conf,"Demo");

job.setJarByClass(Demo.class);

// 源目录 从hdfs读下来 放到 map中 在map中清洗数据

FileInputFormat.setInputPaths(job, new org.apache.hadoop.fs.Path("hdfs://192.168.159.1:8020/flume"));

//!!!!从虚拟机里读取文件,清洗后放入hdfs中 file:

//FileInputFormat.setInputPaths(job, new Path("file:/action-data/contest/online_retailers"));

job.setMapperClass(MapOne.class);//第一个门卫

job.setMapOutputKeyClass(Text.class);//想要通过的人

job.setMapOutputValueClass(LongWritable.class);//通行证上面的戳

// 把map的数据导入reduce中

job.setReducerClass(ReduceOne.class);//第二个门卫

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(LongWritable.class);

//把reduce中 通过清洗的数据 导回指定目录

FileOutputFormat.setOutputPath(job, new org.apache.hadoop.fs.Path("hdfs://192.168.159.1:8020/flume/output"));

//sqoop配置mysql

boolean flag = job.waitForCompletion(true);

System.exit(flag?0:1);

}public class MapOne extends Mapperpublic class ReduceOne extends Reducer

hadoop jar hadooptest.jar demo.Demo

文章标题:大数据开发:(三)flume上传HDFS

文章链接:http://soscw.com/index.php/essay/90186.html