开源蜘蛛集合(转自haizhiguang博客,链接:http://blog.csdn.net/haizhiguang/article/details/20209573)

2021-06-07 22:02

标签:att gen comm 准备 ++ font ide 种类 fit

各种蜘蛛:

Heritrix 点击次数:1458

Heritrix是一个开源,可扩展的web爬虫项目。Heritrix设计成严格按照robots.txt文件的排除指示和META robots标签。

WebSPHINX 点击次数:777

WebSPHINX 点击次数:777

WebSPHINX是一个Java类包和Web爬虫的交互式开发环境。Web爬虫(也叫作机器人或蜘蛛)是可以自动浏览与处理Web页面的程序。WebSPHINX由两部分组成:爬虫工作平台和WebSPHINX类包。

J-Spider 点击次数:1008

J-Spider 点击次数:1008

J-Spider:是一个完全可配置和定制的Web Spider引擎.你可以利用它来检查网站的错误(内在的服务器错误等),网站内外部链接检查,分析网站的结构(可创建一个网站地图),下载整个Web站点,你还可以写一个JSpider插件来扩展你所需要的功能。

Arachnid 点击次数:487

Arachnid 点击次数:487

Arachnid:是一个基于Java的web spider框架.它包含一个简单的HTML剖析器能够分析包含HTML内容的输入流.通过实现Arachnid的子类就能够开发一个简单的Web spiders并能够在Web站上的每个页面被解析之后增加几行代码调用。 Arachnid的下载包中包含两个spider应用程序例子用于演示如何使用该框架。

【Java开源 Web爬虫】列表

http://www.ideagrace.com/sf/web-crawler/

http://www.cs.cmu.edu/~rcm/websphinx/

C#开源示例

http://www.codeproject.com/useritems/ZetaWebSpider.asp

http://www.codeproject.com/aspnet/Spideroo.asp

http://www.codeproject.com/cs/internet/Crawler.asp

说是大全,其实不然,也就是了解到的有这么多,如果大家还有什么好的,请留言发布方便大家交流学习

spider是搜索引擎的必须模块.spider数据的结果直接影响到搜索引擎的评价指标.

第一个spider程序由MIT的Matthew K Gray操刀该程序的目的是为了统计互联网中主机的数目

Spier定义(关于Spider的定义,有广义和狭义两种).

- 狭义:利用标准的http协议根据超链和web文档检索的方法遍历万维网信息空间的软件程序.

- 广义:所有能利用http协议检索web文档的软件都称之为spider.

其中Protocol Gives Sites Way To Keep Out The ‘Bots Jeremy Carl, Web Week, Volume 1, Issue 7, November 1995 是和spider息息相关的协议,可以参考robotstxt.org.

Heritrix

Heritrix is the Internet Archive‘s open-source, extensible, web-scale, archival-quality web crawler project.

Heritrix (sometimes spelled heretrix, or misspelled or missaid as heratrix/heritix/heretix/heratix) is an archaic word for heiress (woman who inherits). Since our crawler seeks to collect and preserve the digital artifacts of our culture for the benefit of future researchers and generations, this name seemed apt.

语言:JAVA, (下载地址)

WebLech URL Spider

WebLech is a fully featured web site download/mirror tool in Java, which supports many features required to download websites and emulate standard web-browser behaviour as much as possible. WebLech is multithreaded and comes with a GUI console.

语言:JAVA, (下载地址)

JSpider

A Java implementation of a flexible and extensible web spider engine. Optional modules allow functionality to be added (searching dead links, testing the performance and scalability of a site, creating a sitemap, etc ..

语言:JAVA, (下载地址)

WebSPHINX

WebSPHINX is a web crawler (robot, spider) java class library, originally developed by Robert Miller of Carnegie Mellon University. Multithreaded, tollerant HTML parsing, URL filtering and page classification, pattern matching, mirroring, and more.

语言:JAVA, (下载地址)

PySolitaire

PySolitaire is a fork of PySol Solitaire that runs correctly on Windows and has a nice clean installer. PySolitaire (Python Solitaire) is a collection of more than 300 solitaire and Mahjongg games like Klondike and Spider.

语言:python , (下载地址)

The Spider Web Network Xoops Mod Team

The Spider Web Network Xoops Module Team provides modules for the Xoops community written in the PHP coding language. We develop mods and or take existing php script and port it into the Xoops format. High quality mods is our goal.

语言:php , (下载地址)

Fetchgals

A multi-threaded web spider that finds free porn thumbnail galleries by visiting a list of known TGPs (Thumbnail Gallery Posts). It optionally downloads the located pictures and movies. TGP list is included. Public domain perl script running on Linux.

语言:perl , (下载地址)

Where Spider

The purpose of the Where Spider software is to provide a database system for storing URL addresses. The software is used for both ripping links and browsing them offline. The software uses a pure XML database which is easy to export and import.

语言:XML , (下载地址)

Sperowider

Sperowider Website Archiving Suite is a set of Java applications, the primary purpose of which is to spider dynamic websites, and to create static distributable archives with a full text search index usable by an associated Java applet.

语言:Java , (下载地址)

SpiderPy

SpiderPy is a web crawling spider program written in Python that allows users to collect files and search web sites through a configurable interface.

语言:Python , (下载地址)

Spidered Data Retri

Spider is a complete standalone Java application designed to easily integrate varied datasources. * XML driven framework * Scheduled pulling * Highly extensible * Provides hooks for custom post-processing and configuration

语言:Java , (下载地址)

webloupe

WebLoupe is a java-based tool for analysis, interactive visualization (sitemap), and exploration of the information architecture and specific properties of local or publicly accessible websites. Based on web spider (or web crawler) technology.

语言:java , (下载地址)

ASpider

Robust featureful multi-threaded CLI web spider using apache commons httpclient v3.0 written in java. ASpider downloads any files matching your given mime-types from a website. Tries to reg.exp. match emails by default, logging all results using log4j.

-

网络数据抓取框架 TinySpider

TinySpider是一个基于Tiny HtmlParser的网络数据抓取框架。 Maven引用坐标:

org.tinygroup tinyspider0.0.12 -

脚本编程语言 CrawlScript

JAVA平台上的网络爬虫脚本语言 CrawlScript 网络爬虫即自动获取网页信息的一种程序,有很多JAVA、C++的网络爬虫类库,但是在这些类库的基础上开发十分繁琐,需要大量的代码才可以完成一个简单 的操作。鉴于这个问题,我们开发了CrawlScript这种脚本语言,程...更多CrawlScript信息

-

Nutch的AJAX页面抓取插件 nutch-htmlunit

Apache Nutch自带的Http Fetch组件对于AJAX类型页面基本是熟视无睹,因此基于Htmlunit组件实现Nutch Plugin形式提供AJAX类型页面抓取解析支持。更多nutch-htmlunit信息

-

网络爬虫 goodcrawler

goodcrawler(GC) 网络爬虫 GC是一个垂直领域的爬虫,同时也是一个拆箱即用的搜索引擎。 GC基于httpclient、htmlunit、jsoup、elasticsearch。 GC的特点: 1、具有DSL特性的模板。 2、分布式、可扩展。 3、辛亏有htmlunit,它能较好地支持JavaScript。 5、合...更多goodcrawler信息

-

垂直爬虫 webmagic

webmagic的是一个无须配置、便于二次开发的爬虫框架,它提供简单灵活的API,只需少量代码即可实现一个爬虫。 以下是爬取oschina博客的一段代码: Spider.create(new SimplePageProcessor("http://my.oschina.NET/", "http://my.oschina.net/*/blog/*")).t...

更多webmagic信息

更多webmagic信息

最近更新: webmagic 0.4.2发布,Java爬虫框架 发布于 2个月前

-

检索爬虫框架 heyDr

heyDr是一款基于java的轻量级开源多线程垂直检索爬虫框架,遵循GNU GPL V3协议。 用户可以通过heyDr构建自己的垂直资源爬虫,用于搭建垂直搜索引擎前期的数据准备。

更多heyDr信息

更多heyDr信息 -

opm-server-mirror

代码更新 2009-11-25: 加入反爬虫功能。直接Web访问服务器将跳转到Google。 使用方法 下载index.zip 解压index.zip得到index.php 将index.php传到支持php和cURL的国外服务器上 打开 http://www.your_website.com/your_folder_if_any/ ,如果页面跳转到Goo...更多opm-server-mirror信息

-

Java网络蜘蛛/网络爬虫 Spiderman

Spiderman - 又一个Java网络蜘蛛/爬虫 Spiderman 是一个基于微内核+插件式架构的网络蜘蛛,它的目标是通过简单的方法就能将复杂的目标网页信息抓取并解析为自己所需要的业务数据。 主要特点 * 灵活、可扩展性强,微内核+插件式架构,Spiderman提供了多达 ...更多Spiderman信息

-

web 搜索和爬虫 Leopdo

用JAVA编写的web 搜索和爬虫,包括全文和分类垂直搜索,以及分词系统更多Leopdo信息

-

OWASP AJAX Crawling Tool

OWASP AJAX Crawling Tool (FuzzOps-NG) OWASP出品的ajax爬虫,java编写,开放源代码。更多OWASP AJAX Crawling Tool信息

-

Ajax爬虫和测试 Crawljax

Crawljax: java编写,开放源代码。 Crawljax 是一个 Java 的工具用于自动化的爬取和测试现在的 Ajax Web 应用。更多Crawljax信息

-

Common Crawl

commoncrawl 源码库是用于 Hadoop 的自定义 InputFormat 配送实现。 Common Crawl 提供一个示例程序 BasicArcFileReaderSample.java (位于 org.commoncrawl.samples) 用来配置 InputFormat。...更多Common Crawl信息

-

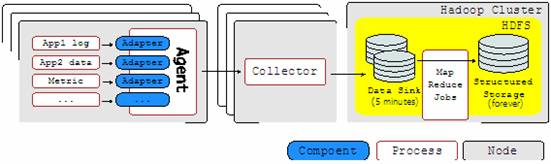

数据收集系统 Chukwa

什么是 Chukwa,简单的说它是一个数据收集系统,它可以将各种各样类型的数据收集成适合 hadoop 处理的文件保存在 HDFS 中供 Hadoop 进行各种 MapReduce 操作。Chukwa 本身也提供了很多内置的功能,帮助我们进行数据的收集和整理。 为了更加简单直观的展示 ...

更多Chukwa信息

更多Chukwa信息 -

简易HTTP爬虫 HttpBot

HttpBot 是对 java.Net.HttpURLConnection类的简单封装,可以方便的获取网页内容,并且自动管理session,自动处理301重定向等。虽然不能像HttpClient那样强大,支持完整的Http协议,但却非常地灵活,可以满足我目前所有的相关需求。...更多HttpBot信息

-

Web挖掘工具包 Bixo

Bixo 是一个开放源码的Web挖掘工具包,基于 Hadoop 开发和运行。通过建立一个定制的级联管总成,您可以快速创建Web挖掘是专门为特定用例优化的应用程序。更多Bixo信息

-

Web爬虫程序 CrawlZilla

crawlzilla 是一個幫你輕鬆建立搜尋引擎的自由軟體,有了它,你就不用依靠商業公司的收尋引擎,也不用再煩惱公司內部網站資料索引的問題 由 nutch 專案為核心,並整合更多相關套件,並開發設計安裝與管理UI,讓使用者更方便上手。 crawlzilla 除了爬取基本...

更多CrawlZilla信息

更多CrawlZilla信息 -

网页爬虫 Ex-Crawler

Ex-Crawler 是一个网页爬虫,采用 Java 开发,该项目分成两部分,一个是守护进程,另外一个是灵活可配置的 Web 爬虫。使用数据库存储网页信息。更多Ex-Crawler信息

-

网页抓取工具 PlayFish

playfish是一个采用java技术,综合应用多个开源java组件实现的网页抓取工具,通过XML配置文件实现高度可定制性与可扩展性的网页抓取工具 应用开源jar包包括httpclient(内容读取),dom4j(配置文件解析),jericho(html解析),已经在 war包的lib下。 这个项...更多PlayFish信息

-

web爬虫 jcrawl

jcrawl是一款小巧性能优良的的web爬虫,它可以从网页抓取各种类型的文件,基于用户定义的符号,比如email,qq.更多jcrawl信息

-

Java多线程Web爬虫 Crawler4j

Crawler4j是一个开源的Java类库提供一个用于抓取Web页面的简单接口。可以利用它来构建一个多线程的Web爬虫。 示例代码: import java.util.ArrayList; import java.util.regex.Pattern; import edu.uci.ics.crawler4j.crawler.Page; import edu.uci.ics.cr...更多Crawler4j信息

-

Web爬虫框架 Smart and Simple Web Crawler

Smart and Simple Web Crawler是一个Web爬虫框架。集成Lucene支持。该爬虫可以从单个链接或一个链接数组开始,提供两种遍历模式:最大迭代和最大深度。可以设置 过滤器限制爬回来的链接,默认提供三个过滤器ServerFilter、BeginningPathFilter和 RegularE...更多Smart and Simple Web Crawler信息

-

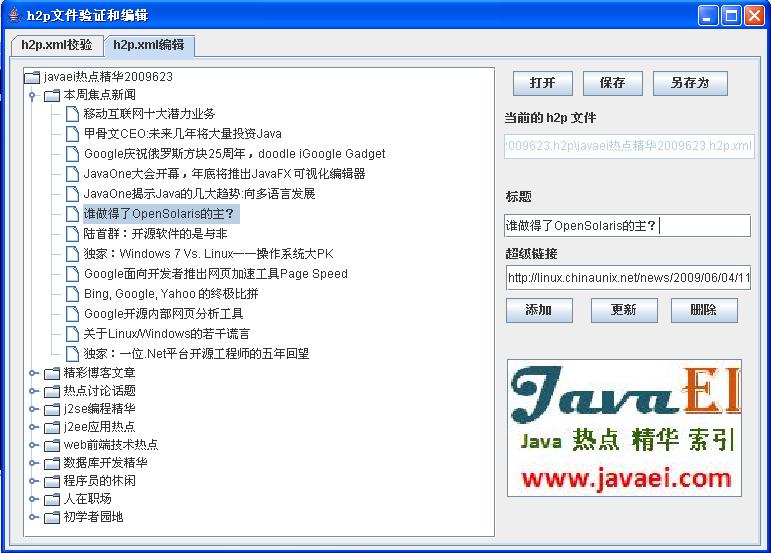

根据URL生成PDF的工具 h2p

根据批量URL生成一个有书签的pdf文档的解决方案。h2p-file是一个xml文件,该xml文件主要描述url的信息和url的层次结构,h2p-tool根据h2p-file生成有书签的pdf文档。还可以通过xsl直接展示url的层次结构,而且合作网站对h2p的支持也将变得简单...

更多h2p信息

更多h2p信息 -

网页搜索爬虫 BlueLeech

BlueLeech是一个开源程序,它从指定的URL开始,搜索所有可用的链接,以及链接之上的链接。它在搜索的同时可以下载遇到的链接所指向的所有的或预定义的范围的内容。更多BlueLeech信息

-

招聘信息爬虫 JobHunter

JobHunter旨在自动地从一些大型站点来获取招聘信息,如chinahr,51job,zhaopin等等。JobHunter 搜索每个工作项目的邮件地址,自动地向这一邮件地址发送申请文本。更多JobHunter信息

-

Java网页爬虫 JSpider

JSpider是一个用Java实现的WebSpider,JSpider的执行格式如下: jspider [URL] [ConfigName] URL一定要加上协议名称,如:http://,否则会报错。如果省掉ConfigName,则采用默认配置。 JSpider 的行为是由配置文件具体配置的,比如采用什么插件,结果存储方...更多JSpider信息

-

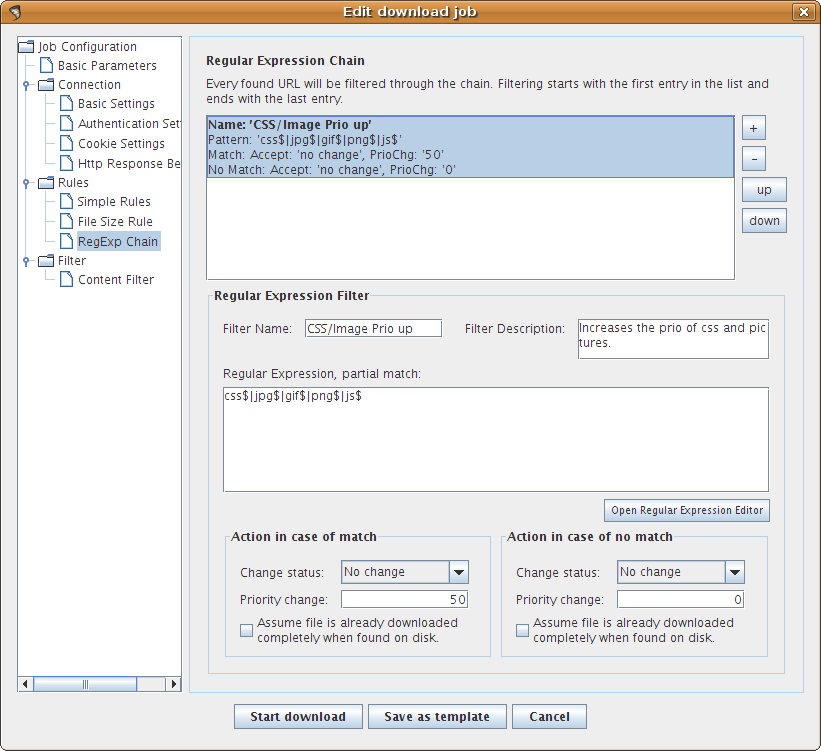

ItSucks

ItSucks是一个java web spider(web机器人,爬虫)开源项目。支持通过下载模板和正则表达式来定义下载规则。提供一个swing GUI操作界面。

更多ItSucks信息

更多ItSucks信息 -

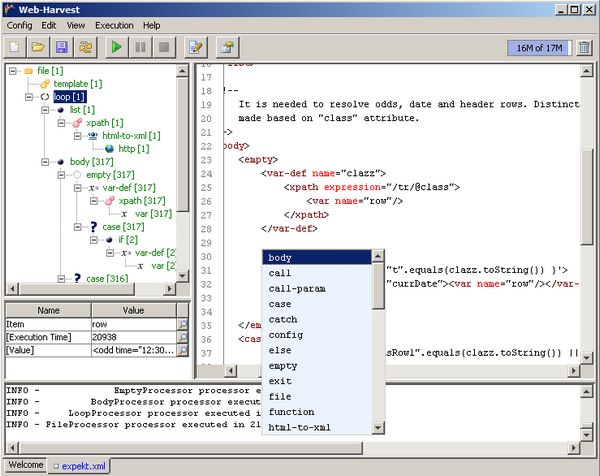

Web-Harvest

Web-Harvest是一个Java开源Web数据抽取工具。它能够收集指定的Web页面并从这些页面中提取有用的数据。Web-Harvest主要是运用了像XSLT,XQuery,正则表达式等这些技术来实现对text/xml的操作。

更多Web-Harvest信息

更多Web-Harvest信息 -

JoBo

JoBo是一个用于下载整个Web站点的简单工具。它本质是一个Web Spider。与其它下载工具相比较它的主要优势是能够自动填充form(如:自动登录)和使用cookies来处理session。JoBo还有灵活的 下载规则(如:通过网页的URL,大小,MIME类型等)来限制下载。...

更多JoBo信息

更多JoBo信息 -

LARM

LARM能够为Jakarta Lucene搜索引擎框架的用户提供一个纯Java的搜索解决方案。它包含能够为文件,数据库表格建立索引的方法和为Web站点建索引的爬虫。更多LARM信息

-

Arachnid

Arachnid是一个基于Java的web spider框架.它包含一个简单的HTML剖析器能够分析包含HTML内容的输入流.通过实现Arachnid的子类就能够开发一个简单的Web spiders并能够在Web站上的每个页面被解析之后增加几行代码调用。 Arachnid的下载包中包含两个spider应用...更多Arachnid信息

-

spindle

spindle是一个构建在Lucene工具包之上的Web索引/搜索工具.它包括一个用于创建索引的HTTP spider和一个用于搜索这些索引的搜索类。spindle项目提供了一组JSP标签库使得那些基于JSP的站点不需要开发任何Java类就能够增加搜 索功能。...更多spindle信息

-

Arale Spider

Arale主要为个人使用而设计,而没有像其它爬虫一样是关注于页面索引。Arale能够下载整个web站点或来自web站点的某些资源。Arale还能够把动态页面映射成静态页面。更多Arale Spider信息

-

WebLech

WebLech是一个功能强大的Web站点下载与镜像工具。它支持按功能需求来下载web站点并能够尽可能模仿标准Web浏览器的行为。WebLech有一个功能控制台并采用多线程操作。更多WebLech信息

-

WebSPHINX

WebSPHINX是一个Java类包和Web爬虫的交互式开发环境。Web爬虫(也叫作机器人或蜘蛛)是可以自动浏览与处理Web页面的程序。WebSPHINX由两部分组成:爬虫工作平台和WebSPHINX类包。

更多WebSPHINX信息

更多WebSPHINX信息 -

web爬虫 Heritrix

Heritrix是一个开源,可扩展的web爬虫项目。Heritrix设计成严格按照robots.txt文件的排除指示和META robots标签。

更多Heritrix信息

更多Heritrix信息 -

网页爬虫 YaCy

YaCy基于p2p的分布式Web搜索引擎.同时也是一个Http缓存代理服务器.这个项目是构建基于p2p Web索引网络的一个新方法.它可以搜索你自己的或全局的索引,也可以Crawl自己的网页或启动分布式Crawling等.更多YaCy信息

最近更新: YaCy 1.4 发布,分布式Web搜索引擎 发布于 10个月前

-

搜索引擎 Nutch

Nutch 是一个开源Java 实现的搜索引擎。它提供了我们运行自己的搜索引擎所需的全部工具。包括全文搜索和Web爬虫。 尽管Web搜索是漫游Internet的基本要求, 但是现有web搜索引擎的数目却在下降. 并且这很有可能进一步演变成为一个公司垄断了几乎所有的web...

开源蜘蛛集合(转自haizhiguang博客,链接:http://blog.csdn.net/haizhiguang/article/details/20209573)

标签:att gen comm 准备 ++ font ide 种类 fit

原文地址:http://www.cnblogs.com/yigui/p/7308333.html

文章标题:开源蜘蛛集合(转自haizhiguang博客,链接:http://blog.csdn.net/haizhiguang/article/details/20209573)

文章链接:http://soscw.com/index.php/essay/91925.html